Vom maschinellen Lernen bis zum intelligenten Roboter − der Begriff „Künstliche Intelligenz“ eröffnet ein großes Spannungsfeld zwischen realistischen Anwendungen und überzogenen Erwartungen. (Bild: Adobe Stock / sdecoret)

Ausgabe lesen

Vom maschinellen Lernen bis zum intelligenten Roboter − der Begriff „Künstliche Intelligenz“ eröffnet ein großes Spannungsfeld zwischen realistischen Anwendungen und überzogenen Erwartungen. (Bild: Adobe Stock / sdecoret)

• 4/2020 • Seite 16

• 4/2020 • Seite 16Der experimentelle Nachweis eines Übergangs beim Betazerfall von hilft dabei, die Entwicklung von Sternen mittlerer Masse genauer vorherzusagen.

• 4/2020 • Seite 18

• 4/2020 • Seite 18Die Spektroskopie hochgeladener Ionen erlaubt mit deutlich erhöhter Auflösung einen präzisen Blick auf die Naturkonstanten.

• 4/2020 • Seite 24

• 4/2020 • Seite 24Treiber, Einsatzfelder und Perspektiven der Künstlichen Intelligenz

Maschinen lernen dank Künstlicher Intelligenz rasend schnell sprechen, sehen, lesen und auch, große Datenmengen nach Mustern zu durchsuchen. Sie werden bald alle Lebensbereiche des Menschen grundlegend verändern. Was treibt diese Entwicklung, wo liegen die Anwendungen, wie intelligent können Maschinen werden und was können Phy- siker dazu beitragen?

Über ein halbes Jahrhundert lang spiegelte der Begriff „Künstliche Intelligenz“ (KI) eher die überzogenen Erwartungen seiner Erfinder wider, als dass er etwas mit der Realität zu tun hatte. In den Jahrzehnten nach 1956, als erstmals ein Forschungsprojekt von Wissenschaftlern um John McCarthy, Marvin Minsky und Claude Shannon so bezeichnet wurde [1], waren die Erfolge überschaubar: Eine Software, die besser Dame spielte als ihr Entwickler, erste selbsttätig fahrende Autos in den 1980er-Jahren, der IBM-Rechner Deep Blue, der 1997 den Schachweltmeister Garri Kasparow besiegte, zweibeinige Roboter wie Hondas Asimo und kleinere Neuronale Netze, welche die Steuerung von Walzwerken und Papierfabriken optimierten – das waren die wesentlichen Meilensteine. (...)

• 4/2020 • Seite 31

• 4/2020 • Seite 31Erkenntnisgewinn durch moderne datengetriebene Methoden

Die Entwicklung neuer Technologien ist entscheidend für Erkenntnisgewinne in der Grundlagen- und angewandten Forschung. Fortschritten bei modernen Datenanalyseverfahren kommt dabei besondere Bedeutung zu: Sie sind der Schlüssel, um neue Erkenntnisse aus Messdaten zu schöpfen und entscheidenden Mehrwert aus Messapparaturen zu erwirken.

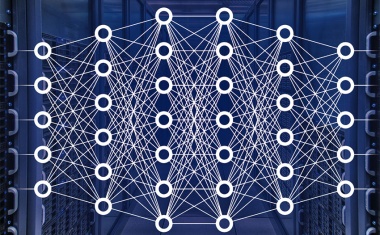

In der Physik werden aktuell Deep Learning-Verfahren bei Fragestellungen erprobt, bei denen sich ein passender Algorithmus nicht so einfach programmieren lässt. Hier weisen Deep Learning-Verfahren häufig Vorteile gegenüber bisher verwendeten Analyseverfahren auf, was zu präziseren wissenschaftlichen Resultaten führt, Erkenntnisprozesse zu mindest beschleunigt oder eventuell erst ermöglicht. Deep Learning beruht auf neuronalen Netzwerken (vgl. dazu die Artikel von Ulrich Eberl und Marco F. Huber sowie die Infoseite „Neuronale Netzwerke kurz erklärt“) [1]. Mit ihnen lassen sich flexible Modelle für beliebige funktionale Zusammenhänge realisieren (Abb. 1). (...)

• 4/2020 • Seite 37

• 4/2020 • Seite 37Cognitive Deep Learning soll neuronale Netze und Wissensverarbeitung kombinieren.

Maschinen sind dem Menschen bei vielen Aufgaben überlegen. Ein Computer führt numerische Berechnungen um Größenordnungen schneller und präziser durch, und auch beim fehlerlosen Speichern und Abrufen großer Datenmengen ist die Maschine ungeschlagen. Was uns auszeichnet, sind die kognitiven Fähigkeiten: Zwar übertreffen künstliche Sensoren unsere Sinneswahrnehmungen, doch in der Verarbeitung dieser Information, also im Lernen, Erinnern und Anwenden, zeigt unser Gehirn seine wahre Leistungsfähigkeit. Durch das sogenannte Deep Learn ing gelang es in den letzten Jahren, den Rückstand von Maschinen bei Mustererkennung, Sprachverarbeitung oder Problemlösefähigkeit deutlich zu verkürzen und in Teilen sogar in eine Überlegenheit zu wandeln.

Von allen Sinnesorganen des Menschen ist der Sehsinn für das Wahrnehmen der Umwelt der wichtigste: Er liefert rund Prozent aller Informationen. Sehen bedeutet, dass elektromagnetische Lichtwellen die Hornhaut und das gesamte Auge durchdringen. Auf der Netzhaut angelangt, regen sie Nervenzellen an, welche die Licht reize über den Sehnerv an das Gehirn weiterleiten. Erst dort entsteht das Bild. Im visuellen Cortex, dem Bereich des Gehirns, der für das Sehen zuständig ist, reagieren Nervenzellen auf unterschiedliche Reize wie bestimmte Farbkombinationen oder Hell-Dunkel-Kontraste. Solche Eindrücke ermöglichen durch den Vergleich mit gespeicherten Bildern das Wiedererkennen eines bekannten Gesichts. (...)

• 4/2020 • Seite 42

• 4/2020 • Seite 42Interview mit den Tübinger Forschern Felix Wichmann und Matthias Bethge zur Robustheit des Sehens und zur Zukunft der KI-Forschung in Deutschland

Der Psychophysiker Felix Wichmann und der Physiker Matthias Bethge wollen den menschlichen Sehprozess genau verstehen, um künstlichen Intelligenzen robustes Sehen beizubringen. Bethge nutzt künstliche neuronale Netze, um das Sehen zu ergründen, Wichmann beschäftigt sich mit den psychologischen Prozessen, die der menschlichen visuellen Wahrnehmung zugrunde liegen.

Sie untersuchen die Robustheit des Sehens. Worum geht es dabei konkret?

Felix Wichmann: Robustes Sehen bedeutet, sich nicht davon beeinflussen zu lassen, dass sich die Randbedingungen radikal ändern. Das stört den Menschen praktisch nicht. Wir können Objekte erkennen, wenn sie halb

verdeckt sind oder wir sie aus einem anderen Blickwinkel sehen beziehungsweise wenn es sehr hell oder dunkel wird. Dieses robuste Sehen möchten wir den Maschinen beibringen.

Worin besteht dabei das Problem?

Matthias Bethge: Wenn neue Daten oder Probleme den Trainingsdaten ähneln, sind Maschinen meistens besser als der Mensch. Aber mit Störungen können sie schlechter umgehen. In unserem Forschungsprojekt untersuchen wir, was die Robustheit des menschlichen Sehens ausmacht.

Wie untersuchen Sie das?

Wichmann: Unser Labor ist komplett schwarz, damit wir die Versuchspersonen gezielt visuellen Reizen aussetzen können, die wir genau unter Kontrolle haben. Ich weiß also exakt, welches Licht mit welcher Wellenlänge den Menschen ins Auge fällt. Darauf bauen wir unsere Modelle auf, um daraus Verhalten vorauszusagen. (...)

712. WE-Heraeus-Seminar