Michael Krieger, Heiko B. Weber und Christopher van Eldik • 12/2022 • Seite 42

Michael Krieger, Heiko B. Weber und Christopher van Eldik • 12/2022 • Seite 42Früh zur Datenkompetenz

An der Universität Erlangen-Nürnberg erlernen Physikstudierende schon im Bachelorstudium Kompetenzen der Datenverarbeitung.

Daten gelten als entscheidende Ressource des 21. Jahrhunderts. In der Physik gibt es eine große Bandbreite strukturierter digitaler Datenströme aus Großexperimenten in Astronomie oder Teilchenphysik, aber auch hochgradig individuell geprägte Datenaufnahme in Laborexperimenten in der Festkörperphysik oder Optik. Wären all diese Forschungsdaten systematisch erfasst und offen zugänglich, ließen sich daraus neue Erkenntnisse gewinnen. Dafür sind neben den Rohdaten auch die Metadaten bedeutsam, die Messaufbau, experimentelle Parameter, Einheiten oder Kontexte beschreiben. Um eine systematische Datenerfassung zu etablieren, gilt es, entsprechende Kompetenzen schon früh im Studium zu vermitteln.

Als Leitgedanke eines Forschungsdatenmanagements dienen die FAIR-Prinzipien: Daten sollen auffindbar (findable), offen zugänglich (accessible), standardisiert und dialogfähig (interoperable) sowie wiederverwertbar (reusable) sein. Solcherart aufbereitete Daten könnten es zukünftig erlauben, mit Computern möglicherweise völlig neue Zusammenhänge zu entdecken. Bund und Länder haben mit der groß angelegten Initiative für eine Nationale Forschungsdateninfrastuktur (NFDI)1) erhebliche Fördermittel bereitgestellt, um Konsortien aus verschiedenen wissenschaftlichen Disziplinen diesbezügliche Konzepte ausarbeiten zu lassen.

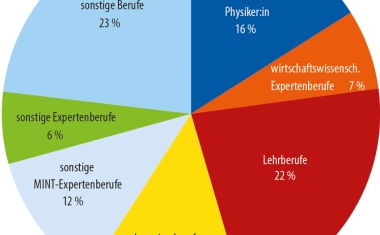

Doch vermitteln unsere Physikstudiengänge überhaupt die passenden Kompetenzen für die Datenverarbeitung? In der Physik besteht breiter weltweiter Konsens, dass die Studierenden fundierte Kenntnisse in Analysis, linearer Algebra etc. haben müssen, um physikalische Konzepte zu verstehen. Ein solcher Konsens bezüglich Datenkompetenzen scheint dagegen nicht zu existieren. Beim Erstkontakt mit Daten, etwa in den Praktika der Experimentalphysik, üben die Studierenden zwar elementare Datenevaluation und systematische Dokumentation, diese genügen aber nicht den steigenden Ansprüchen der Forschung und der Berufspraxis, die sich zunehmend mit der Analyse großer Datenmengen befassen. Häufig scheitert es schon an einem Konsens über eine geeignete Programmiersprache.