Die Aufnahme einer IR-Kamera zeigt, wie sich durch Reibung beim Bremsen sowohl Asphalt als auch Motorradreifen erwärmen. (vgl. S. 47, Bild: Michael Vollmer)

Die Aufnahme einer IR-Kamera zeigt, wie sich durch Reibung beim Bremsen sowohl Asphalt als auch Motorradreifen erwärmen. (vgl. S. 47, Bild: Michael Vollmer)

• 9/2013 • Seite 18

• 9/2013 • Seite 18Experimente mit Gruppen von chemischen oder mechanischen Oszillatoren haben die spontane Symmetriebrechung der Synchronisation nachgewiesen.

• 9/2013 • Seite 20

• 9/2013 • Seite 20Neue Beobachtungen deuten auf die Existenz exotischer Bausteine der hadronischen Materie.

• 9/2013 • Seite 25

• 9/2013 • Seite 25Eine Delegation untersucht die Zone um das zerstörte Kernkraftwerk Fukushima.

Auch zweieinhalb Jahre nach der Katastrophe ist Fukushima regelmäßig in den Medien präsent – zuletzt, als bekannt wurde, dass radioaktiv verseuchtes Wasser ins Meer fließt. Von der Öffentlichkeit weitgehend unbemerkt schreiten die Aufräumarbeiten aber ebenso voran wie die japanischen Bemühungen, die Auswirkungen des Unfalls und der Strahlung zu untersuchen. Im Zuge einer Kooperation zwischen der Fukushima University und der Colorado State University erhielt eine amerikanische Delegation die einzigartige Möglichkeit, dorthin vorzudringen, wo wenige freiwillig hin möchten – und noch weniger vorgelassen werden: in die „Todeszone“ rund um das havarierte Kraftwerk Fukushima Daiichi.

Die Erinnerungen an die düsteren Tage im sonnigen März 2011, als die ganze Welt sorgenvoll nach Japan blickte, kommen uns unweigerlich in den Sinn, als wir im sonnigen Juni 2013 aus dem Shinkansen an jener Station aussteigen, die sinnbildlich für das Versagen der Technik zu stehen scheint: Fukushima. An zahlreichen Messstationen in Fukushima City zeigen große Displays für alle sichtbar die Dosisleistungswerte – sie unterscheiden sich weder von den Werten unserer Messgeräte (0,15 µSv/h) noch vom Dosisleistungshintergrund in Fort Collins (Heimatstadt der Colorado State University am Fuße der Rocky Mountains). Dennoch reichte die unsichtbare Aura der Stadt, um die Zahl der ausländischen Gaststudenten von mehreren Dutzend vor dem Unfall auf null zu senken.

Die Angehörigen der Fukushima University scheinen gezeichnet vom Stigma, das der Stadt anhaftet. Als hätten sie mit dem Erdbeben, dem Tsunami und dann rund 2000 Flüchtlingen, die in der Turnhalle dieser kleinen, 5000 Studenten zählenden Universität untergebracht wurden, nicht schon genug zu ertragen gehabt. Nun beteiligt sich die Universität an Kampagnen, die das Vertrauen der Verbraucher in Lebensmittel und andere Erzeugnisse aus der Präfektur wiederherstellen soll. Kein einfaches Unterfangen in Zeiten, in denen dubiose Geschäftsleute mit noch dubioseren Messungen die Gegend unsicher machen und den verängstigten Hausbesitzern suggerieren, ihr Grundbesitz sei mit 70 µSv/h hochkontaminiert. Daraus ließe sich eine externe Jahresdosis von 600 mSv ableiten. Ein Blick auf die derzeitigen Kontaminationskarten legt jedoch nahe, dass die wahren Werte in jener Gegend wohl mindestens um einen Faktor 100 niedriger liegen – was jenen, die kostspielige Dekontaminationsmaßnahmen anbieten, aber das Geschäft verderben würde. Die tatsächliche Jahresdosis von 1 bis 5 mSv liegt zwar wohl über dem in Deutschland für die Allgemeinbevölkerung gültigen Grenzwert von 1 mSv (ohne natürliche und medizinische Bestrahlung), ist aber so niedrig, dass sich gesundheitliche Auswirkungen nicht nachweisen lassen. Für beruflich strahlenexponiertes Personal gilt hierzulande übrigens ein Grenzwert von 20 mSv/Jahr. ...

• 9/2013 • Seite 29

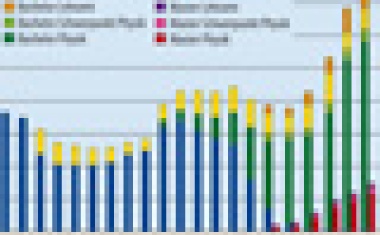

• 9/2013 • Seite 29Statistiken zum Physikstudium an den Universitäten in Deutschland 2013

Zum 26. Mal hat die Konferenz der Fachbereiche Physik (KFP) ihre jährliche Statistik zum Physikstudium in Deutschland erstellt. Die Qualität des Datensatzes für 2013 ist gewohnt hoch: Alle 58 Universitäten und Technische Hochschulen, die einschlägige Studiengänge anbieten, haben sich an der Erhebung beteiligt. Für die Physik-Fachstudiengänge sind die Zahlen bis auf Details (so können einige Universitäten keine Angaben zu den durchschnittlichen Studiendauern machen, andere wenige erheben keine geschlechtsspezifischen Daten etc.) nahezu vollständig erfasst. Mit etwas größeren Unsicherheiten behaftet sind die Angaben zu den Lehramtsstudiengängen, da die Fachbereiche die entsprechenden Daten meist nicht selbst erheben; einige Fachbereiche konnten deshalb besonders zu den Abschlussprüfungen beim Lehramtsstudium nur lückenhafte Angaben machen.

Besonders interessant ist diesmal die Analyse, ob die immatrikulierten Studienanfänger ihr Studium tatsächlich antreten und ernsthaft verfolgen. Dabei wurde eine erheblich Zahl von „Parkstudierenden“ aufgedeckt, die sich zwar für ein Physikstudium einschreiben, dieses aber nicht aufnehmen. Einige warten vermutlich auf einen Studienplatz in einem anderen Fach und „parken“ solange in der Physik, die an den meisten Standorten keine Zulassungsbeschränkung hat. Andere schreiben sich wohl nur deshalb ein, um die Vorteile des Studierendenstatus zu genießen. Dieses Phänomen erschwert – auch mit Blick auf vergangene Jahre – eine Interpretation der Statistik, vor allem die Ermittlung realer Abbruchquoten. Manches deutet darauf hin, dass die Zahl der Parkstudierenden in den letzten Jahren deutlich gestiegen ist, auch wenn für die Vergangenheit kaum direkte Daten vorliegen. ...

• 9/2013 • Seite 35

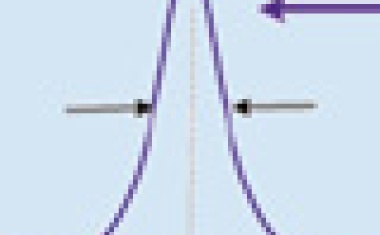

• 9/2013 • Seite 35Optische Nahfelder erlauben die Abbildung über das Abbe-Limit hinaus.

Jedes leuchtende Objekt weist neben dem abgestrahlten Fernfeld auch ein Nahfeld auf, das es wie eine dünne Lichthaut umgibt. Dringt eine Metall- oder Glasfaserspitze darin ein, lässt sich das Objekt mit einer viel höheren Auflösung abrastern als mit einem gewöhnlichen Mikroskop. Die optische Information ergibt sich dabei aus der Intensität des Streulichts der Spitze. Die optische Rasternahfeldmikroskopie hat stimulierend auf eine Reihe moderner Forschungsgebiete gewirkt, z. B. SERS, Plamonik oder optische Antennen.

Klassische optische Mikroskopie hat nach Ernst Abbe eine Auflösungsgrenze von der Größenordnung λ/2. Da die Wellenlänge λ für sichtbares Licht zwischen ca. 400 nm (blau) und 700 nm (purpurrot) liegt, ist diese Grenze bei Abmessungen von 200 bis 350 nm erreicht. Viele heutzutage wichtige Strukturen, beispielsweise von Zellen oder elektronischen Schaltelementen, sind jedoch kleiner. Die Abbe-Grenze lässt sich überwinden, wenn anstelle des optischen Fernfeldes das Nahfeld abgebildet wird. Dies leisten optische Rasternahfeldmikroskope, die Strukturen bis weit in den Nanometer-Bereich abbilden können. Dies erkannte Edward H. Synge intuitiv bereits 1928, was jedoch wieder in Vergessenheit geriet. Erst 40 Jahre später wurde der Effekt mit Radiofrequenzen simuliert und schließlich 1982 durch uns nachgewiesen, patentiert und 1984 veröffentlicht. Die Bedeutung der Nahfeldoptik geht jedoch über die Mikroskopie hinaus. Insbesondere ergibt die Übertragung von Antenneneigenschaften aus dem Hochfrequenz- in den optischen Bereich überraschende Nahfeldeffekte mit Anwendungspotenzial, worauf ich am Ende zu sprechen komme. Doch zunächst: Was sind eigentlich optische Nahfelder?

Elektromagnetische Nah- und Fernfelder entstehen an der Oberfläche jedes (selbst-)leuchtenden oder beleuchteten Körpers. Während das Fernfeld nach den bekannten Gesetzen abgestrahlt wird, bleibt das Nahfeld an den Körper gebunden. Seine Struktur ergibt sich aus den Kontinuitätsbedingungen für das elektrische Feld (E) und die Flussdichte (D) an der Oberfläche. Sie enthält Information über submikroskopische Details der Lichtquelle. Ein ferner Beobachter, der einen Lichtpunkt wahrnimmt, kann deshalb nicht entscheiden, ob es sich um ein submikroskopisches leuchtendes Partikel, ein beleuchtetes Loch mit entsprechenden Abmessungen oder um den beugungsbegrenzten Fokus eines Lichtstrahls handelt. ...

• 9/2013 • Seite 41

• 9/2013 • Seite 41Wie metallische Nanostrukturen neuartige photoelektrische Phänomene ermöglichen.

Der photoelektrische Effekt – kurz Photoeffekt – zählt zu den am besten verstandenen Wechselwirkungen von Licht mit Materie, und seine elementaren Eigenschaften werden bereits im Schulunterricht behandelt. In starken Laserfeldern beobachtet man jedoch ein hiervon drastisch abweichendes Verhalten, das allen weithin bekannten Paradigmen des herkömmlichen Photoeffekts widerspricht. Nanostrukturen bieten dabei besonders faszinierende Systeme, um derartige Prozesse zu studieren und für Anwendungen nutzbar zu machen.

Der Photoeffekt nimmt eine herausragende Rolle im Umbruch der Physik zu Beginn des 20. Jahrhunderts ein. An ihm spitzte sich, ähnlich wie bei der Schwarzkörperstrahlung, besonders deutlich der Widerspruch zwischen der Erwartung der klassischen Physik und den experimentellen Beobachtungen zu. Nach der ursprünglichen Entdeckung der damals als „Lichtelektrizität“ bezeichneten Phänomene durch Heinrich Hertz und Wilhelm Hallwachs machte besonders Philipp Lenard quantitative Bestimmungen, die mit dem damaligen physikalischen Verständnis unvereinbar schienen. Einige Zitate aus Lenards Arbeit von 1902 zeigen dies besonders deutlich. In seinen Experimenten vermaß er die Energie der im Photoeffekt emittierten Elektronen in Abhängigkeit von der Lichtintensität. Seine Erwartung beschrieb er so: Der „vom Lichte stammende Teil der Anfangsgeschwindigkeit ... müsste innerhalb der letzten halben bez. ganzen Resonanzschwingung erworben worden sein, er müsste also mit der Lichtintensität steigen.“ Das Experiment jedoch zeigte anderes: „Es sind aber die Grössen der Anfangsgeschwindigkeiten unabhängig von der Intensität des Lichtes“. Bekanntermaßen löste erst Einstein 1905 mit seiner Quantenhypothese dieses Dilemma auf, indem er postulierte, dass die Elektronen des Festkörpers die Energie des Lichts in unteilbaren Energiequanten aufnehmen.

Heute dient der Photoeffekt routinemäßig als präzise analytische Methode der Festkörper- und Oberflächenphysik. Wir können inzwischen über zeit-, winkel- und energieaufgelöste Photoemissionsspektroskopie genaue Einblicke in die elektronischen Eigenschaften von Festkörpern gewinnen. Hierbei sind die quantenmechanischen Grundlagen des Photoeffekts eine unverzichtbare Selbstverständlichkeit. ...

• 9/2013 • Seite 47

• 9/2013 • Seite 47Mit Wärmebildkameras im Infraroten sehen.

Die visuelle menschliche Wahrnehmung in andere Spektralbereiche zu erweitern – dafür gibt es viele, technisch sogar recht einfache Möglichkeiten. Insbesondere die Infrarotkameras haben sich für Wellenlängen unter 15 µm zu hervorragenden quantitativen Messinstrumenten entwickelt. Zum Einsatz kommen sie in der Grundlagen- und angewandten Forschung sowie zunehmend auch in der Lehre der Physik auf Hochschul- und Schulniveau.

Unter Infrarotkameratechnik, auch Wärmebildtechnik oder Thermographie genannt, versteht man bildgebende Verfahren im infraroten Spektralbereich mit Wellenlängen von etwa 0,9 µm bis 14 µm. Die ursprünglich vor allem militärische Nutzung hat sich in den letzten Jahrzehnten auf weitere Anwendungen in Forschung, Industrie und Technik ausgeweitet. Der Fortschritt in der Mikrosystemtechnik, Optoelektronik und IR-Technik führte einerseits zu immer größerer Produktvielfalt, andererseits zu deutlich preiswerteren und einfacheren Geräten.

Das große Potenzial von IR-Kameras für Lehrzwecke wurde früh erkannt. Dadurch gelang es, insbesondere auch schwer zu visualisierende thermische Vorgänge aus vielen Bereichen der Physik zu untersuchen sowie moderne Anwendungen in der Industrie beispielhaft zu diskutieren.

Wie funktionieren Infrarotkameras?

Wärmebildsysteme basieren auf der Tatsache, dass jedes Objekt mit einer Temperatur über dem absoluten Nullpunkt elektromagnetische Strahlung im infraroten Spektralbereich aussendet. Thermographie detektiert diese Wärmestrahlung und wandelt sie in entsprechende Temperaturprofile der Objekte um. Thermokameras erfassen dabei berührungslos die ausgesandte Eigenstrahlung der Objekte.

Grundlage aller Infrarotsensoren sind das auf Kirchhoff zurückgehende Gesetz zur Absorption und Emission von Strahlung durch Körper sowie die Gesetze der thermischen Strahlung, d. h. Schwarzkörperstrahlung. Demzufolge senden die zu vermessenden Körper thermische Strahlung aus, die lediglich von der Temperatur T und dem Emissionsgrad ε bestimmt wird. Der Emissionsgrad hängt von der Oberfläche und dem Material des Körpers ab. Man unterscheidet schwarze, graue und selektive Strahler. ...

• 9/2013 • Seite 53

• 9/2013 • Seite 53Im Standardmodell der Teilchenphysik ist die Erklärung der Masse der Elementarteilchen mit der Existenz eines neuen und lange gesuchten Teilchens verknüpft: der des Higgs-Bosons.

Die Experimente ATLAS und CMS am Large Hadron Collider (LHC) in Genf haben im Sommer 2012 ein neues Teilchen mit einer Masse von etwa 126 GeV/c2 gefunden, das ein guter Kandidat für das lange gesuchte Higgs-Boson ist. Seit seiner Entdeckung werden die Eigenschaften des neuen Teilchens untersucht.

Das Standardmodell der Teilchenphysik, das die Elementarteilchen und die zwischen ihnen wirkenden Kräfte beschreibt, erklärt alle bislang in Experimenten beobachteten Phänomene der Teilchenphysik. Um die experimentell nachgewiesenen Massen der W- und Z-Bosonen, zwei Austauschteilchen der elektroschwachen Kraft, theoretisch konsistent zu erklären, geht das Standardmodell von der Existenz eines skalaren Feldes aus, des Higgs-Feldes. Die Massen der W- und Z-Bosonen sowie der Quarks und geladenen Leptonen ergeben sich durch die Wechselwirkung der Elementarteilchen mit dem skalaren Higgs-Feld. Eine Konsequenz dieser Beschreibung ist die Existenz eines angeregten Zustandes dieses Feldes in Form eines neutralen, CP-geraden, skalaren Teilchens, des Higgs-Bosons. Seit der Formulierung dieses Mechanismus im Jahre 1964, bekannt als Brout-Englert-Higgs-Mechanismus, wurde an etlichen Experimenten nach Hinweisen auf die Existenz des Higgs-Bosons gesucht. Aus Präzisionsmessungen ergab sich indirekt eine obere Grenze für seine Masse bei 152 GeV/c2. Die Experimente am LEP-Beschleuniger, einem Elektron-Positron-Speicherring am CERN, ergaben, dass die Masse eines Standardmodell-Higgs-Bosons nicht unterhalb von 114,4 GeV/c2 liegen kann. Die Experimente am Tevatron-Beschleuniger, einem Proton-Proton-Speicherring am Fermilab bei Chicago, konnten ein schmales Massenfenster um 160 GeV/c2 ausschließen.

Die Suche nach dem Higgs-Boson war von vornherein eines der wesentlichen Ziele der Experimente am LHC und beeinflusste wichtige Designentscheidungen bei der Planung der ATLAS- und CMS-Detektoren. 2010 fanden im LHC erstmals Protonkollisionen bei einer Schwerpunktsenergie von 7 TeV statt, die bis dahin höchste erreichte Schwerpunktsenergie in einem Hadronenbeschleuniger. Im Sommer 2012 verkündeten die ATLAS- und die CMS-Kollaboration zeitgleich die Entdeckung eines neuen Teilchens mit einer Masse von etwa 126 GeV/c2 mit einer statistischen Signifikanz von 5,9 bzw. 5,0 Standardabweichungen. Von allen möglichen Zerfallskanälen des Higgs-Bosons trugen drei maßgeblich zu der Entdeckung bei: der Zerfall des Teilchens in zwei Photonen, in zwei Z-Bosonen (mit einem anschließenden Zerfall der Z-Bosonen in ein Elektron-Positron-Paar bzw. ein Myon-Antimyon-Paar) und der Zerfall in zwei W-Bosonen, die wiederum in ein Elektron bzw. Myon und ein entsprechendes Neutrino zerfallen. Die ersten beiden Kanäle erlauben es, die Masse des Teilchens sehr gut zu bestimmen, da sich die Endzustände vollständig und mit guter Auflösung im Detektor rekonstruieren lassen.

• 9/2013 • Seite 57

• 9/2013 • Seite 57Wie man junge Menschen für die Naturwissenschaften und Technik begeistern kann

Der einfachste Versuch, den man selbst durchführt, ist besser als der schönste Versuch, den man nur sieht. – Dieser Satz entstammt nicht einem modernen fachdidaktischen Ansatz, sondern ist von Michael Faraday, der im 19. Jahrhundert für seine faszinierenden Weihnachtsvorlesungen bekannt war. Und obwohl diese Erkenntnis noch heute gilt, hat der handlungsorientierte Physikunterricht bei weitem noch nicht die Bedeutung erlangt, die notwendig wäre, um die Attraktivität des Faches Physik zu steigern.

Als Referendar begann ich 1984 an einer Realschule in Südbaden. Mein damaliger Mentor unterschied sich von vielen Physiklehrern, die ich früher kennengelernt hatte. Er gab den Schülerinnen und Schülern und natürlich auch mir immer sehr viel Raum zum Experimentieren. Bei einem Schulfest, das kurz nach meinem Eintritt stattfand, stellte ich im Physiksaal für die Schüler und die übrigen Gäste einige einfache Experimente zum Mitmachen aus. Einige meiner Schülerinnen und Schüler betreuten die Stationen und ermutigten die Besucher zum Mitmachen bei z. B. einem Bernoulli-Ball im Luftstrom oder einem Wasserkocher aus Papier. Die Resonanz war unerwartet hoch und machte mir klar, wie attraktiv das eigene Experimentieren und Mitmachen für Jung und Alt ist.

Wenige Monate danach hatte ich die Möglichkeit, die Phänomena zu besuchen, die im Sommer 1984 in Zürich stattfand. Dieses Wissenschaftsfestival bestärkte und beeinflusste mich sehr nachhaltig. Hier wurden die Naturwissenschaften – in erster Linie die Physik – in ihrer ganzen Schönheit erlebbar gemacht und von den vielen Besuchern auch begriffen. Das mag vielleicht pathetisch klingen, wer aber dort war, konnte erleben, wie sehr die vielen Phänomene die Menschen begeisterten und im wahrsten Sinne beglückten. Sicher lag es auch daran, dass man auf Formeln, Tabellen und Diagramme verzichtete und sich auf Phänomene konzentrierte.

Die Erfahrungen beeinflussten mein Selbstverständnis als junger Lehrer sehr stark. Ich habe erfahren, dass Schüler zuerst begeistert und motiviert werden müssen und dies durch eigenes Experimentieren, freies Forschen und eigene kleine Projekte am besten gelingt. Dann kann man sie auch von der Notwendigkeit überzeugen, sich mit Formeln, Tabelle und Diagrammen zu beschäftigen. Bei meinen eigenen Kindern konnte ich jedoch feststellen, wie fatal sich die Einstellung zur Physik ändert, wenn sie im Anfangsunterricht zu sehr auf Zahlen und Formeln reduziert wird. ...

• 9/2013 • Seite 61

• 9/2013 • Seite 61Das LHeC-Projekt am CERN soll die Erfolgsgeschichte der tiefinelastischen Streuung fortsetzen.

Der rund 60 Jahre alten Methode der Elektron-Nukleon-Streuung sind nicht nur wichtige Beiträge zur Herausbildung der Quantenchromodynamik als Theorie der starken Wechselwirkung zu verdanken, sondern auch viele Resultate zur Quark-Gluon-Struktur des Protons am HERA-Beschleuniger. Ein Elektron-Proton-Kollider viel höherer Luminosität und Energie, der LHeC, verspricht eine Renaissance der tiefinelastischen Elektron-Nukleon-Streuung und kann den LHC zu einer Präzisionsfabrik für das Higgs-Boson machen.

Bis 1955 galt das Proton als elementar und strukturlos. Dies änderte sich schlagartig, als in Stanford ein Elektronenstrahl mit damals noch geringer Energie auf ein Protonentarget geschossen und die Winkelverteilung der gestreuten Elektronen vermessen wurde. Da bei großen Polarwinkeln von mehr als 90° das Ergebnis von der theoretischen Erwartung abwich, musste das Proton einen endlichen Radius von etwa rp ≅0,7 fm haben, über den die elektrische Ladung ausgedehnt ist.

Bei diesem Streuexperiment erkundet ein zwischen Elektron und Proton ausgetauschtes virtuelles Photon die Protonstruktur. Dabei ergibt sich die Photonmasse aus dem Viererimpulsübertrag zwischen Elektron und Proton, Mγ2=Q2. Die Elektronenstreuung an Protonen oder anderen Kernen entspricht einem Mikroskop, da Q2 indirekt proportional zum räumlichen Auflösungsvermögen ρ ist, mit √Q2·ρ=0,2 GeV · fm. Die zur Verfügung stehende Gesamtenergie der ep-Reaktion ist durch s=2Mp Ee gegeben mit der Masse des Protons Mp . Für den maximalen Impulsübertrag gilt Q2≤ s, d. h. mit der Energie Ee=188 MeV des Stanford-Versuchs ist √Q2 etwa 0,2 GeV. Folglich waren damals Dimensionen von ρ≅10–15 m=1 fm zu erreichen. ...

• 9/2013 • Seite 67

• 9/2013 • Seite 67Quasiteilchen an quantenkritischen Punkten

In der Festkörperphysik hat sich das Konzept von Quasiteilchen als äußerst fruchtbar erwiesen. Damit gelingt es, das komplizierte Vielteilchensystem der Elektronen in Metallen auf ein Fermi-Gas von Quasiteilchen mit effektiven Massen zu reduzieren. Eine Erweiterung dieses Konzeptes erlaubt es sogar, die komplexen Eigenschaften von „Schwere-Fermionen-Verbindungen“ in der Nähe eines Quantenphasenübergangs zu verstehen.

Erst die Quantentheorie hat es erlaubt, die Eigenschaften von Metallen zu verstehen. Arnold Sommerfeld schlug 1926 vor, das System der Leitungselektronen in Metallen als entartetes Fermi-Gas aufzufassen, dessen Fermi-Temperatur TF mit rund 104 K weit oberhalb der Raumtemperatur liegt. Daraus lassen sich Eigenschaften wie die Temperaturabhängigkeit der spezifischen Wärme CV (proportional zu T) oder der magnetischen Suszeptibilität χ (unabhängig von T) ableiten, die allgemein als Kennzeichen metallischen Verhaltens dienen. Allerdings leuchtet nicht sofort ein, warum die Coulomb-Wechselwirkung zwischen den Elektronen nur eine geringe Rolle spielen soll. Immerhin ist die entsprechende Energieskala durch die Bindungsenergie des Wasserstoffatoms charakterisiert, die einer Temperatur von 105 K entspricht! Nun schirmen in Metallen die umgebenden Elektronen zwar die Coulomb-Wechselwirkung zwischen zwei Leitungselektronen ab, aber die verbleibende Energieskala ist immer noch von der Größenordnung von TF. Des Rätsels Lösung gab Lew D. Landau 1957, als er zuerst phänomenologisch postulierte und später mikroskopisch begründete, dass es in Metallen wohldefinierte Anregungungen mit fermionischem Charakter gibt. Diese Landau-Quasiteilchen bilden näherungsweise ein Fermi-Gas. Die effektive Masse m* eines Quasiteilchens ist ein wichtiger Parameter der Theorie, der z. B. die Zustandsdichte an der Fermi-Kante renormiert, N(EF) ∝ m* . Damit sind auch thermodynamische Ableitungen wie CV oder χ proportional zu m*. ...

• 9/2013 • Seite 73

• 9/2013 • Seite 73Instrument der A1-Kollaboration in Mainz erzielt hohe Nachweiseffizienz bei niedrigen Kosten.

Der Nachweis von Neutronen gewinnt zunehmend Bedeutung in der Kern- und Teilchenphysik, da Details ihrer Wechselwirkung wichtige Informationen liefern können, beispielsweise in der Astroteilchenphysik zur Modellierung von Neutronensternen. Bislang sind diese Observablen jedoch wegen der Herausforderungen beim Nachweis der Neutronen experimentell nur ungenau bestimmt.

Mit den in der Teilchenphysik gebräuchlichen Detektoren ist Neutronen – verglichen mit geladenen Teilchen – nur schwer und indirekt beizukommen. Wegen ihrer fehlenden Ladung tauschen sie sich nicht über die Coulomb-Kraft mit Atomen oder Molekülen aus und können bei hohen Energien deshalb in Materie viele Zentimeter zurücklegen. Wenn sie wechselwirken, geschieht dies im Wesentlichen aufgrund der starken Kraft: Zwischen einem Neutron und einem Atomkern sind dabei unterschiedliche Prozesse möglich, beispielsweise elastische und inelastische Streuung oder Neutroneneinfang. In diesen Prozessen können sekundäre geladene Teilchen entstehen, die sich konventionell nachweisen lassen, z. B. durch Ausnutzung der Ionisation, die James Chadwick 1932 zur Entdeckung des Neutrons verhalf, oder der Szintillation. Bei der Szintillation wird die Energie von geladenen Teilchen oder energiereichen Photonen in Lichtquanten im sichtbaren Spektralbereich konvertiert, die photosensitive Detektoren − meist Photomultiplier − registrieren. Als Szintillatormaterialien eignen sich spezielle anorganische Kristalle, organische Stoffe oder auch Gase.

Für den Nachweis von Neutronen mit Impulsen von etwa 1 bis 103 MeV/c bietet sich die elastische (n,p)-Streuung: n + p → n + p an. Abb. 1 zeigt den simulierten Nachweis eines Neutrons in einem Detektor, der aus einzelnen Szintillatorelementen besteht. Als Folge der Kernreaktion ändert das Neutron entweder seine Richtung (n), oder es entstehen sogar weitere Neutronen (n*). Diese haben dann meist eine niedrige Energie und erzeugen deshalb kein Signal im Szintillator. Ein Signal tritt dagegen dann auf, wenn die Kernreaktion durch elastische (n,p)-Streuung ein Rückstoßproton (p) hervorbringt, welches das Szintillatormaterial anregt. ...

9/2013 • Seite 89

9/2013 • Seite 89Jahresbericht des Vorstands und der Geschäftsführung zu Aufgaben und Aktivitäten der DPG, aus dem Physikzentrum Bad Honnef und dem Magnus-Haus Berlin

532. WE-Heraeus-Seminar

WE-Heraeus-Physikschule