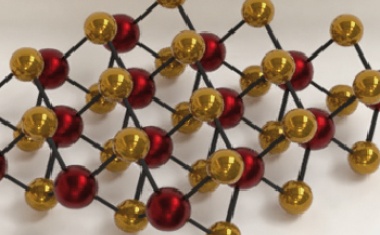

Zweidimensionale Materialien besitzen einzigartige Eigenschaften und ermöglichen eine neuartige Elektronik. (Bild: S. Staacks, vgl. S. 29)

Ausgabe lesen

Zweidimensionale Materialien besitzen einzigartige Eigenschaften und ermöglichen eine neuartige Elektronik. (Bild: S. Staacks, vgl. S. 29)

• 10/2019 • Seite 25

• 10/2019 • Seite 25Vor 100 Jahren entwickelte Otto Stern die bahnbrechende Molekularstrahlmethode.

Extrem genau präparierte Strahlen aus Atomen bzw. Molekülen gehören heute zum unverzichtbaren Werkzeug in Atom-, Molekül-, Cluster- und Oberflächenphysik. Otto Stern entwickelte dafür ab 1919 seine Molekularstrahlmethode, die sich sehr rasch als wegweisend für die Quantenmechanik erweisen sollte, nicht zuletzt als Grundlage für das Stern-Gerlach-Experiment.

Im Jahr 1911 machte der französische Physiker Louis Dunoyer eine wichtige Beobachtung: Die Moleküle eines Gases, die von einem höheren Druckbereich durch eine kleine Öffnung in ein Vakuum (Druck < 10–3 Torr) strömen, bewegen sich geradlinig. Das überraschte eigentlich nicht, denn aufgrund der Gesetze der klassischen Physik muss sich jedes Molekül wegen der Impulserhaltung so lange geradlinig bewegen, bis es durch ein Kraftfeld oder durch Stoß mit einer anderen Masse seinen Impuls und damit Bewegungsrichtung und Geschwindigkeit ändert. Entscheidend war jedoch, dass Dunoyer auf diese Weise erstmals einen Atomstrahl erzeugen konnte [1].

Aufbauend auf dieser Beobachtung begann Otto Stern 1919 in Frankfurt mit der Entwicklung der Molekularstrahlmethode (MSM), die auf einer präzisen transversalen Kollimation eines gasförmigen Atom- oder Molekülstrahls beruht. Damit sollte es möglich sein, den Ablenkwinkel und damit den Transversalimpuls eines im Vakuum fliegenden Teilchens mit extrem hoher Genauigkeit zu präparieren und somit mit hoher Genauigkeit messen zu können. Man kann nur spekulieren, ob ihm damals bewusst war, welche Impulsauflösung die Molekularstrahlmethode einmal liefern würde...

• 10/2019 • Seite 29

• 10/2019 • Seite 29Van-der-Waals-Kräfte erlauben es, aus zweidimensionalen Materialien Heterostrukturen mit maßgeschneiderten Eigenschaften aufzuschichten.

Neue Materialien zu entdecken und geschickt zu nutzen, ist ein Garant für den technologischen Fortschritt. Ein prominentes Beispiel ist die Rolle von Silizium in der modernen Mikroelektronik. Zweidimensionale Materialien, insbesondere kombiniert zu Van-der-Waals-Heterostrukturen, besitzen einzigartige Eigenschaften und ermöglichen eine neuartige Elektronik und integrierte Optoelektronik.

Zweidimensionale Materialien zeichnen sich durch außergewöhnliche Eigenschaften aus. Beispielsweise besitzen die Ladungsträger interne Freiheitsgrade wie den Spin, den Pseudospin oder den Valley-Freiheitsgrad [1]. Diese ermöglichen es, quantenmechanische Effekte technologisch zu nutzen, sodass sich die Materialien für die Spintronik und die neuartige Valleytronik anbieten. Beide Technologien ähneln der konventionellen Elektronik. Während dort Elektronen als Träger der elektrischen Ladung dazu dienen, Daten zu speichern, zu bewegen und zu verändern, nutzt die Spintronik dafür die Spinfreiheitsgrade der Elektronen – und die Valleytronik entsprechend den Valley-Freiheitsgrad.

Zweidimensionale Materialien werden aus Van-der-Waals-Materialien hergestellt. Diese besitzen eine ausgedehnte kristalline planare Struktur, die durch starke kovalente Bindungen innerhalb der Ebene und schwache Van-der-Waals-Kräfte senkrecht zu den Ebenen zusammengehalten wird. Das führt zu Schichtsystemen, wobei sich einzelne Lagen durch das Aufbrechen der Van-der-Waals-Bindungen leicht voneinander ablösen lassen, ohne den verbleibenden Kristall oder die entfernte Lage zu beschädigen. So ist es möglich, einzelne Graphen-Lagen (zweidimensionales Material) mit einem Klebeband von einem Graphitkristall (Van-der-Waals-Material) abzuziehen und auf beinahe beliebigen Oberflächen oder Substraten abzulegen. Diese technologisch sehr einfache mechanische Methode der Exfoliation ist auch auf andere Van-der-Waals-Materialien anwendbar. Daher wächst derzeit die Anzahl experimentell zugänglicher zweidimensionaler Kristalle mit den unterschiedlichsten Eigenschaften rasch an. Diese Schichten lassen sich völlig unabhängig von zueinander passenden Gitterkonstanten oder Kristallorientierungen stapeln, sodass Van-der-Waals-Heterostrukturen entstehen. Die Auswahl und Abfolge der Schichten und ihre Orientierung zueinander erlauben es, die physikalischen Eigenschaften der Heterostrukturen maßzuschneidern [2]...

• 10/2019 • Seite 35

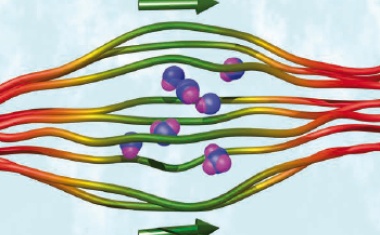

• 10/2019 • Seite 35Polymere Materialien lassen sich so funktionalisieren, dass sie intelligent agieren und autonom Tätigkeiten ausführen können.

Aufgrund ihrer vielfältigen Funktionalisierbarkeit sowie durch Einbindung verschiedener Materialkomponenten lassen sich die Eigenschaften polymerer Materialien auf unterschiedlichste Weise variieren und anpassen. Dadurch können zum Beispiel thermisch oder magnetisch aktivierbare Aktoren entstehen, die mechanisch durch Deformationen auf externe Reize und veränderte Umgebungsbedingungen reagieren. Ein wesentliches Ziel besteht darin, autonom agierende polymere Systeme zu entwickeln, die nach einmaliger Aktivierung selbstständig eine gewünschte Tätigkeit ausführen.

Wann können Moleküle, Materialbausteine und Materialien als „intelligent“ gelten? Zunächst sollte ein solches Material „fähig“ sein, eine komplexe Aufgabe zu erfüllen. Beispielsweise wird an Mikrokapseln aus weichen Gelen geforscht, die unter passenden Umgebungsbedingungen gezielt Medikamente freisetzen. Zusätzlich sollte ein intelligentes Material „schlau“ genug sein, weitgehend selbstständig auf einen äußeren Reiz zu reagieren. Das heißt, die gewünschte Reaktion, etwa eine mechanische Deformation, folgt eigenständig als Antwort auf den äußeren Reiz. Etwas subjektiver ist von einem intelligenten Material eine „gewitzte“ oder „geniale“ Lösung eines gestellten Problems zu erwarten. Durch Optimierung seiner Komponenten und inneren Struktur wird dem Material „gelehrt“, die ihm übertragenen Aufgaben zur maximalen Zufriedenheit zu erfüllen.

Polymere Materialien sind ideale Kandidaten, um derartige Ziele zu erreichen. Einzelne Polymermoleküle bestehen aus einer enormen Zahl identischer Wiederholeinheiten, den Monomeren, die durch chemische Bindungen zu einem Makromolekül verknüpft sind. Solche Moleküle lassen sich synthetisch herstellen, kommen aber auch in der Natur vor. Aufgrund ihrer Größe ist es möglich, bereits auf einem einzigen Molekül unterschiedliche Funktionalitäten und Informationen zu speichern. Ein sehr prominentes Beispiel ist die menschliche DNA. Entlang dieses linearen Biopolymermoleküls ist über die räumliche Abfolge und Wiederholung von vier verschiedenen Monomeren die Erbinformation kompakt gespeichert. In gestrecktem Zustand ist das Molekül knapp zwei Meter lang. Wir haben es also im wahrsten Sinne des Wortes mit einem Makromolekül zu tun. Obwohl schätzungsweise wenige Kubikmeter DNA genügen, um das gesamte, globale menschliche Wissen zu kodieren, würden wir das Molekül für sich allein im obigen Sinne nicht als „intelligent“ bezeichnen. Die DNA kann zwar die Information tragen, wie auf externe Stimuli zu reagieren ist, benötigt im Organismus aber noch den biologischen Zellapparat, um entsprechende Aufgaben abzuarbeiten...

• 10/2019 • Seite 43

• 10/2019 • Seite 43Ein Diskussionsbeitrag: Was wurde im Stromsektor in den letzten 18 Jahren erreicht?

In der Märzausgabe ging es um die Frage, wie die Ziele der Energiewende bis 2050 zu erreichen sind [1]. Mittels Sektorenkopplung lassen sich die CO2-Emissionen um 80 bis 85 Prozent senken. Mein Beitrag versucht eine Zwischenbilanz der Energiewende und hält fest, was bislang erreicht wurde. Dabei beschränke ich mich auf den Stromsektor, auf dem sich – anders als bei Wärmeversorgung oder Mobilität – der technische Wandel schnell vollzieht und erste Erfahrungen gesammelt wurden.

Im Jahr 2000 trat das Erneuerbare-Energien-Gesetz in Kraft. In Deutschland wurden die Jahre 2002 bis 2018 genutzt, um Wind- und Wasserkraft, Photovoltaik sowie Strom aus Biomasse als erneuerbare Energien um 100 GW auszubauen. Nach einer stürmischen Entwicklung lieferten diese Techniken 2018 einen zusätzlichen Energiebeitrag von 180 TWh. Noch 31 Jahre bleiben bis 2050 – dem Jahr, bis zu dem die Politik die Energiesysteme hin zu einer weitgehend CO2-freien Versorgung umgebaut haben will.

Bis 2016 hat die Kapazität der installierten Leistung fossiler Energien leicht zugenommen (Abb. 1a). Die Ausnutzung der Kohlekraftwerke in Volllaststunden (full-load hours, flh) sank jedoch – für Braun- bzw. Steinkohle im Mittel um 26 bzw. 57 Stunden pro Jahr (h/a). Die Nutzung von Gas nahm im Mittel um 80 h/a zu. Der Energieertrag der Kernenergie sank aufgrund des 2011 verfügten Endes von acht Kraftwerken und aufgrund des Abbaus weiterer Kapazitäten in den Folgejahren (Abb. 1b). Die Volllaststunden der verbliebenen Kraftwerke nahmen jedoch um 14 h/a zu! Die erneuerbaren Energien verzeichneten einen starken Zuwachs (Abb. 1c). Die flh-Werte von Onshore-Windenergie betrugen im Mittel der Jahre 2005 bis 2018 etwa 1650 h/a, entsprechende Werte für Offshore-Windenergie lagen um 3350 h/a. Beide lassen keinen Trend erkennen. Die PV-Werte betrugen über dasselbe Zeitfenster im Mittel 820 h/a – mit wachsendem Trend (flh etwa 1000 h in 2018)...

• 10/2019 • Seite 50

• 10/2019 • Seite 50Interview mit Michael Kaschke

Schon in der Schulzeit erwachte bei Prof. Dr. Michael Kaschke (62) das Interesse an der Laserphysik. Auch in Promotion und Habilitation widmete er sich diesem Thema. 1992 startete er als wissenschaftlicher Mitarbeiter bei ZEISS. 2000 wurde er in den Vorstand berufen, dessen Vorsitzender er seit 2011 ist. 2009 wurde er Honorarprofessor an der Fakultät für Elektrotechnik und Informatik des Karlsruher Instituts für Technologie, wo er regelmäßig Vorlesungen, unter anderem zur Medizintechnik, hält.

Wieso haben Sie Physik studiert?

Physikalische Phänomene haben mich schon immer interessiert, und zu meiner Schulzeit setzte sich der Laser in technischen Anwendungen mehr und mehr durch. Das war für mich ein Grund, in Jena zu studieren. Die dortige Universität hat einen sehr guten Ruf, speziell in der Laserphysik.

Mit welchen Themen haben Sie sich während der Promotion beschäftigt?

Mit der Erzeugung ultrakurzer Lichtpulse und deren Vermessung. Später in der Habilitation habe ich diese Pulse genutzt, um schnelle Vorgänge in Molekülen zu vermessen, also Ultrakurzzeit-Spektroskopie zu betreiben.

Wieso haben Sie sich gegen die Karriere in der Wissenschaft entschieden?

Ich hatte die Gelegenheit, als Invited Visiting Scientist am IBM Research Center in den USA zu arbeiten. Dort habe ich erste Industrieluft geschnuppert. Zurück in Deutschland war mir klar, dass ich Forschung und Wissenschaft mit mehr Anwendungsnähe betreiben möchte. ZEISS bot mir diese Möglichkeit und passte auch inhaltlich genau zu meinen Interessen...

Kernfusion und Plasmaphysik waren Themen bei einer Fachexkursion der jungen DPG.