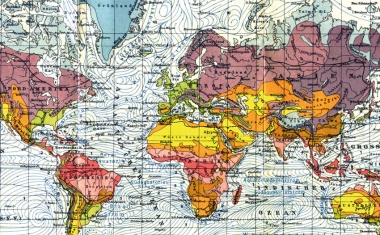

Voraussetzung für Klimamodelle sind Simulationen, wie hier des Wärmetransports im Ozean. Bis zur modernen Klimaforschung mit komplexen Modellen war es ein langer Weg. (Bild: Los Alamos National Laboratory, vgl. S. 22)

Ausgabe lesen

Voraussetzung für Klimamodelle sind Simulationen, wie hier des Wärmetransports im Ozean. Bis zur modernen Klimaforschung mit komplexen Modellen war es ein langer Weg. (Bild: Los Alamos National Laboratory, vgl. S. 22)

Die Stadt Jena wurde wegen ihrer reichen physikalischen Kultur zur "EPS Historic Site" gekürt.

IBM und Fraunhofer-Gesellschaft haben den derzeit leistungsstärksten Quantencomputer in Europa installiert.

Das Deutsche Zentrum für Luft- und Raumfahrt hat drei neue Institute eröffnet.

Die Internationale Energieagentur beschreibt in einer Roadmap drei Szenarien, von denen eines bis zum Jahr 2050 zu Null Emissionen netto führen soll.

Zahlreiche Nobelpreisträgerinnen und -träger und weitere Persönlichkeiten rufen zum Handeln auf, um die globalen Probleme zu bewältigen.

Mit der Grundsteinlegung beginnt die Hochbauphase für das neue Gebäude des Max-Planck-Zentrums für Physik und Medizin.

Bei FAIR ist der Rohbau für den Ringbeschleuniger SIS100 vollendet.

Mit vielen Aktionen würdigt die Helmholtz-Gemeinschaft den 200. Geburtstag von Hermann von Helmholtz.

Das Max-Planck-Institut für Astronomie hat ein Citizen-Science-Projekt initiiert, um quallenförmige Galaxien in simulierten Daten aufzuspüren.

Die ESA hat die Themenfelder veröffentlicht, für die sie im Planungszyklus "Voyage 2050" große Missionen plant.

Auch Chinas Mars-Rover ist jetzt auf dem Roten Planeten unterwegs.

Ob und wie Quanten- und Weltraumforschung in Horizon Europe für Institutionen assoziierter Länder zugänglich werden, steht noch nicht endgültig fest.

• 7/2021 • Seite 22

• 7/2021 • Seite 22Wie der Klimawandel in Wissenschaft und Politik gelangte

In der Wissenschaft war der Treibhauseffekt schon am Ende des 19. Jahrhunderts bekannt, Beobachtungen in den 1930er-Jahren deuteten darauf hin, dass die globalen Temperaturen ansteigen. Trotzdem war der Weg von der klassischen Klimatologie zur modernen Klimawissenschaft lang und von gesellschaftlichen, politischen und technischen Entwicklungen entscheidend beeinflusst.

Bereits 1896 sagte der schwedische Physiker Svante Arrhenius wegen des rasch wachsenden Kohleverbrauchs und der damit verbundenen Kohlendioxidemissionen steigende globale Temperaturen voraus. Zu diesem Zeitpunkt stieß diese Erkenntnis jedoch auf wenig Interesse. Etwa vierzig Jahre später beobachteten Meteorologen tatsächlich einen signifikanten Anstieg der Temperaturen in Europa, der in der Arktis besonders ausgeprägt war. Der englische Ingenieur Guy Callendar versuchte 1938 durch umfangreiche Berechnungen nachzuweisen, dass der Treibhauseffekt diesen Anstieg verursacht haben könnte (Abb. 1). Zu seiner Überraschung traf seine Theorie in der Meteorologie und Klimatologie auf große Skepsis. Möglich schienen auch zufällige Verschiebungen der globalen Windzirkulation als Ursache für den Temperaturanstieg.

Es dauerte weitere vier Jahrzehnte, bis weiterhin steigende Kohlendioxidemissionen ernsthafte Befürchtungen über eine Klimaerwärmung verursachten und zu einem Politikum wurden. Paradoxerweise wandelte sich diese Wahrnehmung zu einem Zeitpunkt, als die Entwicklung der globalen mittleren Temperaturen seit rund drei Jahrzehnten wieder stagnierte. Beobachtungen wiesen also keineswegs auf einen Klimawandel wie in den 1930er-Jahren hin. Was verursachte also die plötzliche Sorge über einen Klimawandel? Und warum erhielten die Klimawissenschaften in den folgenden Jahrzehnten hohe politische Priorität, nicht aber vierzig Jahre zuvor? Dieser Beitrag versucht, Antworten auf diese Fragen zu geben.

Die Tradition der „klassischen Klimatologie“

Das Interesse am Klima reicht weit zurück. Griechische Philosophen wie Parmenides, Eratosthenes, Aristotle und Hippokrates verstanden unter dem griechischen Wort κλίμα (klíma) den Winkel der Sonneneinstrahlung. Seefahrer und Reisende berichteten in den folgenden Jahrhunderten über die Verschiedenheit von Klimata auf dem Globus und zeigten, dass nicht der Sonnenwinkel allein das Klima bestimmte. Jahreszeiten, Wetter, Windströmungen und terrestrische Verhältnisse wie Entfernung von den Ozeanen und die Höhe über dem Meer machten das Klima zu einem weitaus komplexeren Phänomen. Eine wissenschaftliche Klimatologie entstand im Laufe des 19. Jahrhunderts. (...)

• 7/2021 • Seite 28

• 7/2021 • Seite 28Ein physikalischer Chemiker in der Kälteindustrie – beraubt, vertrieben und ermordet.

Als die „Carl von Linde Denkmünze“ des Deutschen Kälte- und Klimatechnischen Vereins am 25. September 1952 in Stuttgart verliehen wurde, fiel in der Dankesrede des Preisträgers Franz Simon (1893 – 1956) unerwartet der Name von Franz Pollitzer. Im Auditorium spürte man, wie das konzentrierte Zuhören für einen Moment einem betretenen Schweigen wich. Simon, der 1933 nach England emigriert war, wollte mit Pollitzer an einen befreundeten Kollegen erinnern, der die an ihn verliehene Medaille für die Anwendung der Tieftemperaturphysik in der Industrie eigentlich weitaus mehr verdient hätte. Aber Franz Pollitzer war in Auschwitz ermordet worden.

Pollitzers Vater Adam (1835 – 1899), der aus Ungarn stammte, ließ sich in Wien nieder, wo er seit 1867 ein Kurzwarengeschäft betrieb, 1868 Pauline Spitzer (1847 – 1903) heiratete und dann hauptsächlich mit Kurrentwaren handelte, also mit Erzeugnissen aus Seide, Stoff oder Wolle. Mit wenigstens zwei Söhnen zog die Familie 1872 nach Gablonz in Böhmen um, wo sie sich weiter vergrößerte, zuletzt am 14. November 1885 mit der Geburt des fünften und jüngsten Kindes Franz. 1891 gingen die Pollitzers nach Berlin. Franz besuchte dort die Luisenstädtische Oberrealschule, an der er zu Ostern 1904 die Reifeprüfung ablegte. Inzwischen hatte er schon beide Eltern verloren.

Im Sommersemester 1904 begann er sein Studium der Chemie und Physik an der Berliner Universität. Im Winter ging er für ein Semester nach Wien an die Technische Hochschule und die Universität, hörte unter anderem bei Ludwig Boltzmann und konvertierte im März 1905 zum Katholizismus. Ab Ostern 1905 setzte er sein Studium wieder an der Berliner Universität fort. Pollitzer promovierte bei Walther Nernst mit einer im April 1909 abgeschlossenen Untersuchung über das Gleichgewicht zwischen Schwefelwasserstoff und Jod, die unter Abscheidung von Schwefel und Bildung von Jodwasserstoff reagieren. Nernst würdigte diese Arbeit abschließend mit den Worten: „… da sowohl die Darstellung wie insbesondere die theoretische Verarbeitung der erhaltenen Ergebnisse überall eine gute Begabung und ein ungewöhnlich tiefes Verständnis erkennen läßt (sic), so bringe ich das Prädikat „valde laudabile“ in Vorschlag.“ Die vier mündlichen Prüfungen absolvierte Pollitzer am 15. Juli 1909 ebenfalls mit sehr gutem Ergebnis, wobei er in der Physik von Max Planck Fragen über Prinzipien der Mechanik sowie in der Elektrizität etwa über die galvanische Kette oder das Ohmsche Gesetz zu beantworten hatte. Mit dem Druck der Arbeit erfolgte die Promotion am 9. Oktober 1909. (...)

• 7/2021 • Seite 32

• 7/2021 • Seite 32Das Projekt DEAL hat Verträge mit zwei großen Wissenschaftsverlagen ausgehandelt.

Die COVID-19-Pandemie hat mit aller Deutlichkeit gezeigt, wie wichtig es ist, aktuelle wissenschaftliche Erkenntnisse möglichst rasch und breit verfügbar zu machen, um sie in- und außerhalb der Wissenschaft zu nutzen. Damit wissenschaftliche Erkenntnisse nicht hinter (Bezahl-)Schranken verborgen bleiben und um ihre Sichtbarkeit zu steigern, setzt sich die Allianz der deutschen Wissenschaftsorganisationen seit vielen Jahren dafür ein, das wissenschaftliche Publikationssystem auf Open Access umzustellen. Die „Berlin Declaration on Open Access“ wurde im Oktober 2003 veröffentlicht. Mittlerweile haben diese fast 690 Institutionen unterzeichnet. Leider fehlt die DPG, obwohl sie zusammen mit dem Institute of Physics 1999 das New Journal of Physics gegründet hat und damit zu den Open-Access-Vorreitern zählt.

Ein Jahrzehnt nach der Berliner Erklärung, nachdem neue Open-Access-Zeitschriften gegründet und an vielen Institutionen entsprechende Repositorien als Teil einer weltweiten Infrastruktur für Open Access aufgebaut worden waren, erschienen nicht mehr als zehn Prozent der weltweit in wissenschaftlichen Zeitschriften veröffentlichten begutachteten Arbeiten Open Access. Gleichzeitig beurteilen laut einer Studie, an der sich mehr als 40 000 Wissenschaftlerinnen und Wissenschaftler beteiligten, fast 90 Prozent der Befragten Open Access als positiv [1]. Somit sind neue, koordinierte Strategien nötig, um Open Access als Standard insbesondere in etablierten Zeitschriften zu verankern. Auch die internationale Initiative OA2020 zielt darauf ab, diesen Übergang durch eine zügige und wissenschaftskonforme Transformation des Geschäftsmodells der heutigen wissenschaftlichen Zeitschriften zu beschleunigen – und dabei geschätzte Funktionen wie Peer Review zu erhalten.

Um dies in Deutschland umzusetzen, beschlossen die Präsidentinnen und Präsidenten der Allianz-Organisationen 2016, unter dem Namen DEAL (DEutsche Allianz Lizenzen) Verhandlungen mit den drei größten Wissenschaftsverlagen aufzunehmen. Basis war die Erkenntnis, dass ein stabiler Übergang zu einem Open-Access-Publikationssystem mit den bisher für das Subskriptionssystem aufgewendeten finanziellen Mitteln möglich ist: Laut einer Studie der Max Planck Digital Library (MPDL) beträgt der weltweite Subskriptionsumsatz der Wissenschaftsverlage rund 7,6 Milliarden Euro [2]. Das entspricht für jeden der etwa zwei Millionen Artikel pro Jahr rund 3800 Euro, im Wesentlichen gespeist aus den Budgets der Bibliotheken. Aber die durchschnittlichen Publikationsgebühren (Article Processing Charge, APC) liegen in reinen Open-Access-Zeitschriften deutlich unter 2000 Euro pro veröffentlichtem Artikel, wie Daten der DFG, des SCOAP3-Konsortiums und der OpenAPC-Initiative zeigten. (...)

• 7/2021 • Seite 35 • DPG-Mitglieder

• 7/2021 • Seite 35 • DPG-MitgliederDie Ergebnisse der ersten Umfrage des Konsortiums NFDI4Phys liefern wertvolle Einsichten in den Umgang mit Forschungsdaten in der Physik.

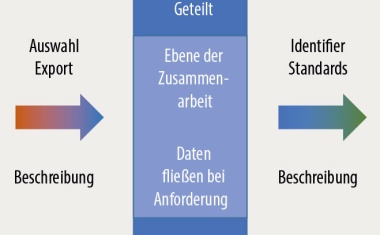

In die wissenschaftliche Arbeit fließen Daten ein: Messwerte aus dem Labor, Berechnungen von Computern und Forschenden oder Daten anderer Gruppen. Ein Ziel des Datenmanagements muss darin bestehen, wichtige Forschungsdaten dauerhaft zugänglich, nutzbar und nachprüfbar zu machen. Das soll die von Bund und Ländern initiierte Nationale Forschungsdateninfrastruktur (NFDI) vereinfachen.

Diese Forschungsdateninfrastruktur wird in die europäische und weltweite Forschungsdatenlandschaft (z. B. European Open Science Cloud) eingebettet sein. International etabliert ist hierbei die Einhaltung der FAIR-Prinzipien: Daten müssen demnach „findable, accessible, interoperable, reusable“ sein, also auffindbar, zugänglich, interoperabel und wiederverwendbar [1]. Beschäftigt man sich dafür mit Dokumentation, Archivierung, Transformation oder der Veröffentlichung von Forschungsdaten, spricht man vom Forschungsdatenmanagement.

In der Informationswissenschaft ist das Konzept der Wissenspyramide gebräuchlich [2, 3]: Ausgehend von bloßen Daten über strukturierte Informationen (z. B. durch geeignete Metadaten annotierte Daten) steigt der Erkenntnisgewinn hin zum Wissen und schließlich zur Weisheit. Daten und Informationen können hierbei Individuen, Gruppen oder einer breiten Öffentlichkeit zugänglich sein [4]. Daraus ergeben sich verschiedene Wege zur Erkenntnis (Abb. 1): Forschende können Wissen aus ihren eigenen, individuellen Daten destillieren und veröffentlichen. Andererseits steht die (eigene) Forschung durch Ergebnisse anderer Forschender in einem größeren Kontext und ermöglicht es, auf öffentlicher Ebene Wissen zu gewinnen. Beide Wege haben ihre Berechtigung und sind in der Physik verbreitet.

Daher zielen die Konsortien der NFDI darauf ab, die Forschungsdateninfrastruktur fachspezifisch auszugestalten. Forschende sollen definieren, welche Anforderungen und Wünsche sie daran haben. In drei Förderrunden von 2019 bis 2021 empfehlen Gutachterinnen und Gutachter, die von der Deutschen Forschungsgemeinschaft (DFG) bestellt wurden, die geeignetesten Konsortien zur Förderung im Rahmen der NFDI. (...)

• 7/2021 • Seite 39 • DPG-Mitglieder

• 7/2021 • Seite 39 • DPG-MitgliederDie Einzelatom-Elektronenspinresonanz erlaubt es, Atome und Moleküle mit sehr hoher Auflösung zu charakterisieren.

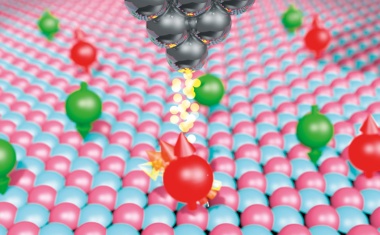

Die Spinresonanz kommt in Kernspintomografen und in Analysegeräten in der Physik, Chemie und Biologie, sowohl in Forschung als auch Industrie zum Einsatz. Eine neue Methode erlaubt Elektronenspinresonanz an einzelnen Atomen und Molekülen in einem Rastertunnelmikroskop und liefert Einblicke in die Wechselwirkungen zwischen Atomen, in die Dynamik ihrer magnetischen Zustände und in die Eigenschaften einzelner Kernspins. Dieser neue Zugang zu atomaren Quantenzuständen könnte auch für die Quanteninformationsverarbeitung interessant sein.

Der Eigendrehimpuls oder auch Spin von fundamentalen Teilchen wie Elektronen ist ein Standardbeispiel für ein quantenmechanisches Zwei-Niveau-System und bildet die Basis für magnetische Phänomene. Auch sind Einzelelektronenspins in verschiedenen Quantenarchitekturen die Basis für Quantenbits für Quantencomputer und andere Quanteninformationsexperimente. Wenn Spins auf der Nanoskala genügend isoliert sind, können sie ihre quantenkohärenten Eigenschaften relativ lange beibehalten. Jedoch ist es dann oft ziemlich schwierig, ihre Zustände zu messen und kohärent zu steuern.

In diesem Artikel stellen wir eine neuartige Methode vor, mit der sich einzelne Spins auf atomarer Skala messen und steuern lassen. Diese basiert auf dem Rastertunnelmikroskop (Scanning Tunneling Microscope, STM), das seit fast vier Jahrzehnten Einblicke in die Nanowelt erlaubt. Für die erste Realisierung erhielten Gerd Binnig und Heinrich Rohrer 1986 den Physik-Nobelpreis. Salopp gesagt funktioniert die Rastertunnelmikroskopie wie das Lesen von Blindenschrift. Allerdings „rastert“ statt des Fingers eine sehr feine Metallspitze über eine Oberfläche (Abb. 1). Mithilfe von Piezomaterialien ist dies so präzise möglich, dass Bilder mit atomarer Auflösung entstehen. Das eigentliche Messsignal ist hier der quantenmechanische Tunnelstrom. Dieser tritt auf, wenn zwischen Probe und Spitze eine elektrische Spannung anliegt und die Spitze durch Adjustieren des Abstandes sehr nah – auf Größenordnungen von einem Nanometer – an die Probe gelangt. Dann können Elektronen von der einen zur anderen Seite tunneln. Durch Regelung des Tunnelstroms auf einen konstanten Wert lässt sich ein Höhenprofil der Oberfläche erzeugen. Dies macht einzelne Objekte wie Atome sichtbar (Abb. auf Seite 39). Damit erlaubte das STM – zusammen mit dem Rasterkraftmikroskop [1] – neue Einblicke in die Welt der kleinsten Materiebausteine, was in Bereichen wie der Festkörperphysik, der Physikalischen Chemie oder auch der Biologie Anwendung fand. Zudem kann die Spitze die Atome auf der Oberfläche präzise „herumschieben“ (Atommanipulation) [2]. (...)

• 7/2021 • Seite 46 • DPG-Mitglieder

• 7/2021 • Seite 46 • DPG-MitgliederUltrakalte Atome liefert neue Einblicke in topologische Quantenmaterie.

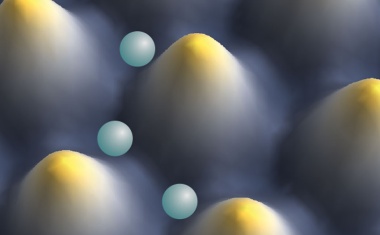

Geschlossene Flächen wie die Oberfläche einer Kugel lassen sich anhand ihrer Topologie klassifizieren, die durch die Anzahl der Löcher des geometrischen Objekts bestimmt ist. Sehr ähnliche Konzepte spielen auch in der Festkörperphysik eine wichtige Rolle. Dort klassifizieren topologische Invarianten Materiezustände nach ihren topologischen Eigenschaften. Topologische Materiezustände zeigen außergewöhnliche Phänomene wie die präzise Quantisierung des Hall-Widerstandes. Diese Eigenschaften lassen sich im Labor auf kontrollierte Art und Weise in Modellsystemen studieren.

Topologie ist ein Konzept aus der Mathematik, das in den letzten Jahrzehnten auch in der Physik an Bedeutung gewonnen hat. Das gilt neben der traditionellen Festkörperphysik zunehmend auch für synthetische Quantenmaterie wie photonische Wellenleiter oder ultrakalte Atome in optischen Gittern [1, 2]. Ein zentrales Beispiel sind topologische Isolatoren, die leitende Randkanäle besitzen, in denen der Strom verlustfrei transportiert wird. Diese Eigenschaft entsteht aufgrund der Topologie des Materials, die durch ganzzahlige topologische Invarianten wie die Chern-Zahl beschrieben sind. Ein topologisch triviales Material hat eine Chern-Zahl ν = 0, ein topologisch nicht-triviales Material ν ≠ 0. Die Chern-Zahl bestimmt die Anzahl der leitenden Randkanäle an der Grenzfläche zu einem topologisch trivialen Material oder dem Vakuum. Für viele Anwendungen sind genau diese Randkanäle interessant, weil sie elektrischen Strom nur in eine Richtung leiten und daher gegen Rückstreuung geschützt sind, also einen verschwindenden elektrischen Widerstand haben.

In diesem Artikel wollen wir die Physik der eher abstrakten topologischen Konzepte anhand von Experimenten mit ultrakalten Atomen in optischen Gittern veranschaulichen. Hierbei kommen im ersten Schritt Laserkühlung und Evaporation zum Einsatz, um Atome auf sehr kalte Temperaturen von wenigen Nanokelvin zu bringen. Dies verringert die Bewegungsenergie der Atome so weit, dass sie in periodischen Potentialen gefangen sind, die durch interferierende Laserstrahlen entstehen (Abb. 1a). Die Bewegung der Atome in diesem künstlichen Kristall aus Laserlicht lässt sich ähnlich wie die Bewegung von Valenzelektronen in einem Festkörper beschreiben. Somit stellt dieses im Labor erzeugte, wohl kontrollierte System ein stark vereinfachtes Modell von Festkörpern dar (Abb. 1b, c) und erlaubt es, deren grundlegende elektronische Eigenschaften zu untersuchen. Diese Quantensimulation der Physik von Festkörpern bietet neue Einblicke, die in vielerlei Hinsicht komplementär zu den Messgrößen in Festkörpern sind [3]. Dieser Ansatz ist besonders vielversprechend für wechselwirkende topologische Zustände, deren Eigenschaften trotz jahrzehntelanger Forschung immer noch Rätsel aufgeben. (...)

• 7/2021 • Seite 52 • DPG-Mitglieder

• 7/2021 • Seite 52 • DPG-MitgliederWie Simulationen reale Experimente ergänzen und das Unsichtbare visualisieren

Reale Phänomene und die unmittelbare Wahrnehmung physikalischer Prinzipien stehen in einem Spannungsfeld zur abstrakten Modellierung und theoretischen Beschreibung der Physik. Sowohl Forschende als auch die Wissensvermittlung müssen Abstraktion und Konkretion zusammenführen. In der Lehre können interaktive Simulationen und virtuelle Lernumgebungen eine Brücke zwischen dem Realen und dem Modellhaften bilden. Interaktive Simulationen ergänzen dabei reale Experimente und helfen, unsichtbare Effekte erlebbar zu machen.

Experimente stellen seit Anfang des 19. Jahrhunderts ein zentrales Unterrichtselement dar. Ihre Eigenschaften haben sich mit der Zeit jedoch verändert [1], zuletzt durch die Möglichkeit, digitale Medien vielfältig einzusetzen. Reale Experimente dienen u. a. dazu, Naturphänomene oder alltagsrelevante Anwendungen darzustellen und zeichnen sich durch ein hohes Maß an Glaubwürdigkeit aus [2]. Studien zeigen, dass es lernförderlich ist, wenn Lehrkräfte und Lernende Experimente angemessen vor- und nachbereiten [3]. Dieser Einbettung kommt dabei auch die Aufgabe zu, experimentelle Erkenntnisse mithilfe eines physikalischen Modells zu analysieren und zu interpretieren.

Um Experimente in den Unterricht einzubetten, bedarf es ergänzender Medien. Dabei stehen neben Schulbüchern, Arbeitsblättern oder dem Tafelanschrieb auch digitale Medien zur Verfügung. Während in den eher traditionellen und analogen Unterrichtsmedien primär statische und visuelle Repräsentationen, wie Texte, Formeln und Zeichnungen, zum Einsatz kommen, ermöglichen digitale Technologien je nach Medium auch den Einbezug dynamischer Visualisierungen, Töne oder auch interaktiver Inhalte. Digitale Medien vergrößern dabei nicht nur den Handlungsspielraum der Lehrkräfte. Weil sie das Sehen und Hören ansprechen, ergänzen sie den Unterricht auch aus kognitionspsychologischer Perspektive [4].

Reale Erfahrungen und modellbezogene Beschreibungen lassen sich mit interaktiven Simulationen besonders gut verbinden. Die Simulationen basieren auf Messdaten oder theoretischen Modellen realer Prozesse bzw. Phänomene. Sie beinhalten statische oder dynamische Visualisierungen sowie teilweise auditive Elemente. Den Nutzenden ermöglichen sie die Variation verschiedener Parameter und so die Untersuchung von Einflüssen auf den dargestellten Prozess – genau wie bei realen Experimenten. Psychologische Modelle beschreiben diese Form des Erkenntnisgewinns als dreistufigen Prozess aus Hypothesenbildung, experimenteller Prüfung und resultierender Schlussfolgerung [5]. (...)

Ein deutsches Team erreicht den zweiten Platz beim Internationalen Physik-Wettbewerb PLANCKS.

Eine Reihe von vier Online-Vorträgen widmet sich Themen aus Astronomie und Raumfahrt.