Wie eine KI viel Energie sparen kann

Neue Art künstlicher neuronaler Netzwerke ebnet den Weg zu einer energieeffizienten KI-Hardware.

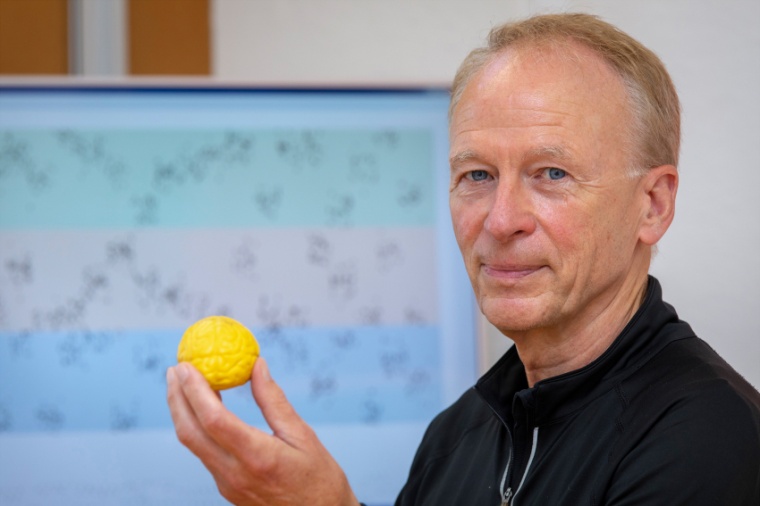

Die meisten neuen Errungenschaften der künstlichen Intelligenz erfordern sehr große neuronale Netze. Sie bestehen aus hunderten Millionen von Neuronen, die in mehreren hundert Schichten angeordnet sind, also sehr tiefe Netzstrukturen haben. Diese großen, tiefen neuronalen Netze verbrauchen im Computer sehr viel Energie. Besonders energieintensiv sind jene neuronalen Netze, die in der Bildklassifizierung eingesetzt werden, da sie in jedem Zeittakt sehr viele Zahlenwerte mit großer Genauigkeit von einer Neuronenschicht zur nächsten senden müssen. Der Informatiker Wolfgang Maass hat nun gemeinsam mit seinem Doktoranden Christoph Stöckl ;eine Design-Methode für künstliche neuronale Netzwerke gefunden, die den Weg zu einer energieeffizienten leistungsfähigen KI-Hardware ebnet.

Die beiden Forscher des Instituts für Grundlagen der Informationsverarbeitung der TU Graz haben künstliche neuronale Netzwerke in Computersimulationen zur Bildklassifizierung derart optimiert, dass die Neuronen – ähnlich wie Neurone im Gehirn – nur relativ selten Signale aussenden müssen und eben diese Signale sehr einfach sind. Die nachgewiesene Klassifizierungsgenauigkeit von Bildern mit diesem Design kommt trotzdem sehr nahe an den aktuellen Stand der Technik derzeitiger Methoden zur Bildklassifizierung heran.

Maass und Stöckl ließen sich dabei von der Arbeitsweise des menschlichen Gehirns inspirieren. Dieses verarbeitet mehrere Billionen Rechenoperationen in der Sekunde, benötigt dafür aber nur etwa zwanzig Watt. Möglich wird dieser geringe Energieverbrauch durch die zwischenneuronale Kommunikation mittels sehr einfacher elektrischer Impulse, den Spikes. Die Information wird dabei nicht nur durch die Anzahl der Spikes, sondern auch durch ihre zeitlichen variablen Muster kodiert. „Man kann sich das vorstellen wie einen Morse-Code. Auch die Pausen zwischen den Signalen übertragen Informationen“, erklärt Maass. Dass eine Spike-basierte Hardware den Energieverbrauch von Anwendungen mit neuronalen Netzen reduzieren kann, ist nicht neu. Dies konnte aber bisher nicht für die sehr tiefen und großen neuronalen Netze realisiert werden die man für wirklich gute Bildklassifikation benötigt.

In der Methode von Maass und Stöckl kommt es nun bei der Informationsübertagung nicht nur darauf an, wie viele Spikes ein Neuron aussendet, sondern auch, wann das Neuron diese Spikes aussendet. Die Zeit oder die zeitlichen Abstände zwischen den Spikes kodieren sich praktisch selbst und können daher sehr viel zusätzliche Information übertragen. „Wir zeigen, dass mit wenigen Spikes – in unseren Simulationen sind es durchschnittlich zwei – genauso viel Informationen zwischen den Prozessoren vermittelt werden können wie in energieaufwendiger Hardware“, so Maass. Mit den Ergebnissen liefern die beiden Informatiker einen neuen Ansatz für Hardware, die wenige Spikes und damit einen geringen Energieverbrauch mit State-of-the-Art-Performances von KI-Anwendungen verbindet. Die Ergebnisse könnten die Entwicklung von energieeffizienter KI-Anwendungen drastisch beschleunigen.

TU Graz / JOL

Weitere Infos

- Originalveröffentlichung

C. Stöckl & W. Maass: Optimized spiking neurons can classify images with high accuracy through temporal coding with two spikes, Nat. Mach. Intell., online 11. März 2021; DOI: 10.1038/s42256-021-00311-4 - Institut für Grundlagen der Informationsverarbeitung, Technische Universität Graz