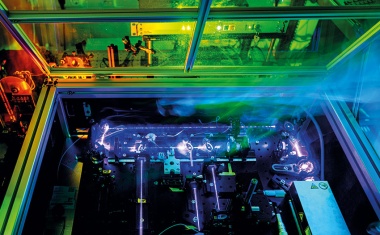

Nichtlineare Interferometer für die spukhafte Bildgebung mit nichtdetektiertem Licht gibt es bereits als transportable Systeme. (Bild: Walter Oppel, Fraunhofer IOF, vgl. S. 40)

Ausgabe lesen

Nichtlineare Interferometer für die spukhafte Bildgebung mit nichtdetektiertem Licht gibt es bereits als transportable Systeme. (Bild: Walter Oppel, Fraunhofer IOF, vgl. S. 40)

• 6/2022 • Seite 24 • DPG-Mitglieder

• 6/2022 • Seite 24 • DPG-MitgliederÜber die Abwanderung von Wissenschaftlerinnen und Wissenschaftlern in die USA nach Ende des Zweiten Weltkriegs

Mit dem Ziel, durch wissenschaftliche Erkenntnisse den Krieg im Pazifik möglichst zu verkürzen, begann im Juli 1945 ein zunächst geheimes US-Rekrutierungsprogramm für ausgewählte deutsche Wissenschaftlerinnen und Wissenschaftler. Nach Kriegsende wurde es unter dem Namen „Paperclip“ weitergeführt.

Nur wenige Themen haben die Politik in den vergangenen Jahren so sehr bewegt wie die Migration. Ein Hauptauslöser dafür, dass Menschen in ein anderes Land auswandern, sind kriegerische Konflikte mit all ihren zerstörerischen Konsequenzen. Auch die Geschichte Deutschlands im 20. Jahrhundert ist geprägt durch das Entfachen von zwei Weltkriegen, in deren Folge Millionen von Menschen verfolgt, ermordet oder vertrieben wurden.

Dieser Beitrag soll die Folgen des Zweiten Weltkriegs um eine weniger bekannte Perspektive ergänzen: eine Auswanderungsbewegung von deutschen und österreichischen Physikerinnen und Physikern nach Ende des Zweiten Weltkriegs in die USA. Teile dieser Geschichte, insbesondere die Überführung von Raketenwissenschaftlern zusammen mit Wernher von Braun und dessen Beteiligung am amerikanischen Raumfahrtprogramm, sind in einigen hervorragenden Büchern und Arbeiten, jedoch auch in einer größeren Anzahl weniger fundiert recherchierten und teils reißerischen Werken erzählt worden. Auch finden sich Karikaturen dieser Karrieren in populären Werken, etwa in der Figur des „Dr. Strangelove“ in Stanley Kubricks gleichnamigen Film von 1964. Im Folgenden wird der Blick hingegen auf Bereiche der Physik gelenkt, die bisher weniger im Zentrum des öffentlichen Interesses standen. (...)

• 6/2022 • Seite 29 • DPG-Mitglieder

• 6/2022 • Seite 29 • DPG-MitgliederAm Large Hadron Collider lassen sich Top-Quarks mit bisher unerreichter Präzision erforschen und damit wegweisende Erkenntnisse für die Teilchenphysik gewinnen.

Ein Vierteljahrhundert nach der Entdeckung des Top-Quarks am Tevatron-Beschleuniger des Fermilab öffnet der Large Hadron Collider am CERN die Tür zu einem neuen Bereich der Teilchenphysik. Entsprach der Weg zur Entdeckung noch der sprichwörtlichen Suche nach der Nadel im Heuhaufen, produziert der LHC heute Top-Quarks millionenfach. Die damit erreichbare Genauigkeit erlaubt nicht nur detaillierte Tests des Standardmodells der Teilchenphysik, sondern kann auch den Weg zu seinen möglichen Erweiterungen weisen.

Das Top-Quark spielt im Standardmodell der Teilchenphysik eine besondere Rolle. In den 1970er-Jahren zeigte sich, dass Fermionen (Teilchen mit halbzahligem intrinsischen Drehimpuls) in Familien auftreten, von denen jede aus zwei Quarks, einem geladenen Lepton und einem Neutrino besteht. Diese Familien unterscheiden sich nur durch die Massen der enthaltenen Fermionen. Anfangs waren nur zwei Familien bekannt: Zur ersten Familie gehören u- und d-Quark, Elektron und Elektron-Neutrino, zur zweiten c- und s-Quark, Myon und Myon-Neutrino. Die Entdeckung des τ-Leptons 1975 und des b-Quarks 1977 lieferten jedoch Hinweise auf eine dritte, schwerere Familie. Zu diesem Zeitpunkt fehlte ihr zugehöriges Neutrino sowie ein zweites Quark, das Top-Quark. Obwohl das Standardmodell außer der Masse alle Teilchen-Eigenschaften vorhersagt, führten die intensiven Suchen erst nach fast zwanzig Jahren zum Nachweis des Top-Quarks. Seine für subatomare Verhältnisse riesige Masse – es ist fast 35-mal schwerer als ein b-Quark und damit fast so schwer wie ein Goldatom – macht das Top-Quark einzigartig und stellte die damaligen Experimente vor große Herausforderungen. (...)

• 6/2022 • Seite 40 • DPG-Mitglieder

• 6/2022 • Seite 40 • DPG-MitgliederWie die Quantenoptik neue Methoden der Bildgebung ermöglicht

Licht fasziniert seit jeher, doch der physikalische Blick darauf bleibt im steten Wandel. Seine einfachste Beschreibung als Strahlenbündel bildet die Basis der geometrischen Optik und erklärt, wie optische Abbildungen mittels Linsen funktionieren. Ein genauerer Blick auf das Verhalten von Licht an einem optischen Gitter zeigt Beugung und Interferenz – zwei Effekte, die in seiner Wellennatur begründet liegen. Aber Licht ist noch viel mehr: Dank Albert Einstein und Max Planck wissen wir heute, dass es aus Quanten besteht: den Photonen. Auf dieser fundamentalen Erkenntnis baut unsere moderne Photonik- und Halbleiterindustrie auf, und damit Quantentechnologien der 1. Generation. Die heute in der Entwicklung befindliche 2. Generation beruht auf nichtklassischen Quantenzuständen des Lichts.

In der Entwicklung der Quantenphysik zeigte sich schnell, dass Licht in Form verschiedener Quantenzustände vorliegen kann. Einige davon lassen sich nicht mehr mit klassischer Elektrodynamik beschreiben. Die Anwendungen dieser nichtklassischen Zustände in neuartigen technologischen Konzepten bilden die Quantentechnologien der 2. Generation und stehen aktuell als Forschungsgebiet mit hohem Innovationspotenzial im Fokus. Ein vielversprechendes Gebiet stellt hierbei die Quantenbildgebung dar: die Bildgebung und Spektroskopie mit nichtklassischem Licht [1].

Die mit Abstand meistgenutzte Quelle nichtklassischen Lichts basiert auf der spontanen parametrischen Fluoreszenz (Infokasten). Dabei konvertieren die Pumpphotonen eines Lasers spontan in zwei Tochterphotonen, die historisch bedingt als Signal und Idler benannt sind. Das Signal- und das Idlerphoton bilden als Photonenpaar einen nichtklassischen Zwei-Photonenzustand mit Eigenschaften, die in der klassischen Optik nicht existieren. Beide Photonen sind räumlich verschränkt – das heißt, sie zeigen Korrelationen sowohl in ihrer Position als auch in ihrem Impuls. Daneben können weitere Freiheitsgrade verschränkt sein, wie Polarisation, Helizität bzw. Drehimpuls oder Energie und Zeit. Darauf basierend lassen sich die verschiedenen Ansätze der Quantenbildgebung in drei Kategorien einteilen. Denn die Quantenbildgebung nutzt entweder Verschränkung aus, basiert auf Korrelationen oder geschieht mithilfe von Interferometern. Im Folgenden illustriert jeweils ein Beispiel diese Kategorien, wobei die letzte sowohl wegen ihrer spukhaften Physik als auch wegen des enormen Anwendungspotenzials genauer beleuchtet wird. (...)

• 6/2022 • Seite 35 • DPG-Mitglieder

• 6/2022 • Seite 35 • DPG-MitgliederDas Lehrkonzept „Peer Instruction“ hilft, das Physikverständnis zu erhöhen.

Die Hochschullehre ist ein wichtiger Forschungsgegenstand, da empirische Daten helfen können, ihre Effektivität zu steigern [1]. Forschungsergebnisse aus dem nordamerikanischen Raum sowie von deutschen Hochschulen belegen, dass interaktive Lernszenarien zum konzeptionellen Physikverständnis mehr beitragen als traditionelle dozentenzentrierte Darbietungen. Die Art und Weise, mit der sich Studierende mit Fachkonzepten auseinandersetzen, trägt wesentlich zum Lernerfolg bei. Ein mögliches Lernszenario ist das Konzept „Peer Instruction“ (PI).

Eric Mazur entwickelte dieses Konzept in den 1990er-Jahren an der Harvard University [2 – 4]. Auslöser dafür, seine Vorlesung radikal vom lehr- zum lernzentrierten Unterricht zu ändern, waren Veröffentlichungen von Ibrahim Abou Halloun und David Hestenes aus den Jahren 1985 und 1987 [5, 6]. Sie hatten den Test „Force Concept Inventory“ zu grundlegenden Konzepten der Newtonschen Mechanik entwickelt und gezeigt, wie wenig die Studierenden in der Physikvorlesung verstanden hatten. Aus Neugier setzte Mazur diesen konzeptionellen Test in seinen Ingenieur- und Physikstudiengängen ein. Sein Schlüsselerlebnis war folgende Frage eines Teilnehmers: „Professor Mazur, wie soll ich diese Fragen beantworten? So wie Sie es uns vorgestellt haben oder wie ich über diese Dinge wirklich denke?“ [4]. Dieses Zitat verdeutlicht, dass Studierende zwar die Inhalte der Physik lernen, deren physikalisches Weltbild mitunter aber häufig unverändert „vor-Newtonisch“ bleibt.

Die Verwendung qualitativer Fragen in späteren Klausuren bestätigte das Ergebnis, dass das konzeptionelle Verständnis der Studierenden bei traditioneller Lehre deutlich hinter der Fähigkeit, Rechenalgorithmen anzuwenden, zurückbleibt. Mazur erkannte dadurch, dass bloßes Zuhören in einer Vorlesung, die als Monolog vor einer passiven Hörerschaft gehalten wird, nicht ausreicht, um die intrinsische Schwierigkeit eines wissenschaftlichen Konzeptes zu verstehen. (...)

Interview mit Babette Döbrich

742. WE-Heraeus-Seminar