Ising-Computer mit zweitausend Spins

Laserpulse steuern optisch parametrische Oszillatoren – und lösen kombinatorische Probleme.

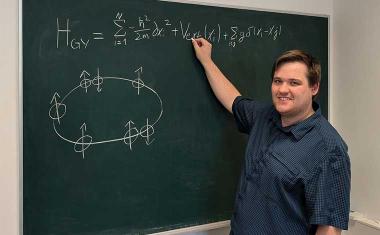

Das Ising-Modell gehört zu den altgedienten Arbeitspferden der statistischen Physik. Ursprünglich im Jahr 1924 vom Doktoranden Ernst Ising auf Anregung seines Doktorvaters Wilhelm Lenz aufgestellt, sollte es das Verhalten von Spins in ferromagnetischen Körpern beschreiben. Ising nahm hierzu an, der Spin könne nur nach oben oder nach unten zeigen und die Werte plus oder minus eins annehmen. Zwischen benachbarten Spins liegt eine Kopplung vor, wobei die Austauschkopplung bei Ferromagnetika positiv, bei Antiferromagnetika negativ ist. Dem Gesamtsystem lässt sich so über eine Hamilton-

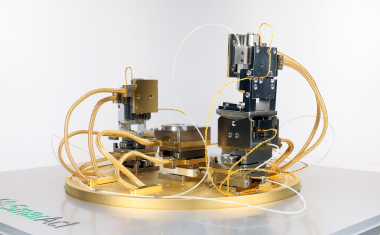

Abb.: Aufbau des Experiments in Stanford. (Bild: A. Marandi, Stanford U.)

Aber nicht nur in der Physik, sondern auch in der Mathematik und Informatik ist das Modell von Interesse. Denn die Kopplungen zwischen den einzelnen Komponenten des Systems müssen nicht auf Nachbarn beschränkt sein, sondern lassen sich im Prinzip beliebig einstellen. In einem allgemeinen Ising-

Interessanterweise eignen sich solche allgemeinen Ising-

Zwei Forscherteams aus den NTT Labs im japanischen Atsugi und der Stanford University in Kalifornien haben deshalb jetzt versucht, dieses Modell mit langreichweitigen Kopplungen umzusetzen. Wenn jeder Spin mit jedem anderen beliebig wechselwirken kann, sind für obiges Problem nur noch tausend physische Spins notwendig, um die eine Million Einträge zählende Matrix physikalisch abzubilden.

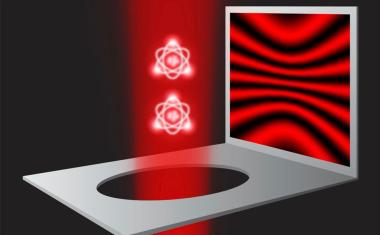

Beide Forscherteams arbeiten mit derselben Technik. Sie integrieren optisch parametrische Oszillatoren, kurz OPOs, in einer bis zu einer Kilometer langen optischen Faser. Diese steuern sie mit zeitlich exakt abgestimmten Pulsen an. Dabei entspricht jeder kurze Laserpuls einem Spin im Ising-

„Es ist uns gelungen, ein Verfahren zur Messung und Feedback-

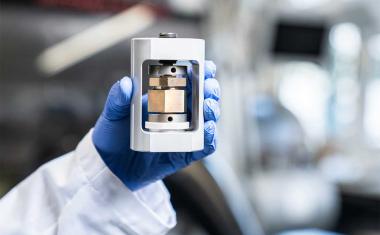

Der Unterschied zwischen den Experimenten der beiden Forschergruppen liegt im Wesentlichen darin, dass die NTT-Forscher ein größeres Netzwerk mit zweitausend physischen Spins aufbauten, während die Gruppe in Stanford nur hundert Spins einsetzt. Der Grund hierfür liegt vor allem darin, dass die Stanford-

Noch sind derartige Computer mit hundert oder zweitausend Bit zwar aufwändig im Bau und in der Ansteuerung. Sollte es den Gruppen aber gelingen, ihr Verfahren weiter nach oben zu skalieren, könnten solche Architekturen vielleicht in Konkurrenz zu normalen von-Neumann-Computern treten. Dabei sind einige IT-Experten durchaus skeptisch, ob dieser Ansatz wirklich große Fortschritte bringt. Im Zweifelsfall hängt es stark von der spezifischen Fragestellung ab, die man bearbeiten will. So ist bei Graphen-

Dabei kommt es aber wieder darauf an, ob man den Grundzustand sucht – was sehr aufwändig ist – oder sich diesem nur bis auf wenige Prozent annähern will und bei einer entsprechenden Konvergenz mit dem Ergebnis zufrieden ist. So benötigte die Maschine in Kalifornien für die Bestimmung des Grundzustands eines solchen Problems zweihundert Millisekunden, für die 95-prozentige Annäherung daran nur vier Millisekunden, bei neunzig Prozent nur eine Millisekunde.

In Zukunft wollen die Forscher ihre Systeme weiter ausbauen. „Wir wollen die Größe unseres Ising-

Dirk Eidemüller

Weitere Infos

RK