Netzwerk schlauer als seine Erfinder

Neue Methode erlaubt neuronalen Netzen, auch nach noch unbekannten Kriterien zu kategorisieren.

Wenn Computer selbstständig auf Satellitenbildern Gewässer und ihre Umrisse erkennen oder beim fernöstlichen Brettspiel Go einen der weltbesten professionellen Spieler schlagen, dann arbeiten im Hintergrund lernfähige Algorithmen. Programmierer haben diese zuvor während einer Trainingsphase mit bekannten Beispielen gefüttert: Bilder von Gewässern und von Land beziehungsweise bekannte Go-

Abb.: Ein einfaches neuronales Netzwerk (Bild: E. P. L. van Nieuwenburg et al.)

Solche künstlichen neuronalen Netzwerke kamen beim maschinellen Lernen bisher dann zum Einsatz, wenn das Unterscheidungskriterium bekannt ist: Man weiß, was ein Gewässer ist und welches in vergangenen Go-

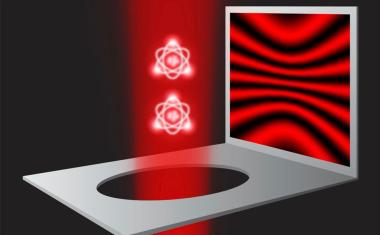

Nun haben Wissenschaftler aus der Gruppe von Sebastian Huber, Professor für theoretische Festkörperphysik und Quantenoptik an der ETH Zürich, die Anwendungen solcher neuronaler Netzwerke erweitert: Sie entwickelten eine Methode, mit der sich beliebige Daten nicht nur kategorisieren lassen, sondern die auch erkennt, ob es in komplexen Datensätzen überhaupt Kategorien gibt.

Solche Fragestellungen gibt es in der Wissenschaft zuhauf: Die Methode könnte für die Auswertung von Messungen an Teilchenbeschleunigern oder von astronomischen Beobachtungen interessant werden. Physiker können damit aus ihren oft unüberschaubaren Messdaten die vielversprechendsten Messungen herausfiltern. Pharmakologen könnten aus umfangreichen Moleküldatenbanken jene Moleküle aussieben, die mit einer gewissen Wahrscheinlichkeit eine bestimmte pharmazeutische Wirkung oder Nebenwirkung haben. Und Datenwissenschaftler könnten damit riesige ungeordnete Datenwulste ordnen und daraus verwertbare Informationen gewinnen (Data-

Die ETH-Forscher wandten ihre Methode unter anderem an einem intensiv erforschten Phänomen der theoretischen Physik an: einem Viel-

Um diese Grenze zu finden, entwickelten die Wissenschaftler das „So tun als ob”-

Insgesamt trainierten sie das Netzwerk unzählige Male, jeweils mit einer anders gewählten Grenze, und sie testeten nach jedem Training, wie gut das Netzwerk Daten zu sortieren vermag. Das Ergebnis: In vielen Fällen bekundete das Netzwerk Mühe, die Daten so einzuteilen, wie von den Wissenschaftlern vorgegeben, in einigen Fällen war die Einteilung in die zwei Gruppen jedoch sehr präzise.

Die Forscher konnten zeigen, dass diese Sortierleistung vom Ort der gewählten Grenze abhängt. Evert van Nieuwenburg, Doktorand in der Gruppe von ETH-Professor Huber, erklärt das so: „Indem ich für das Training eine Grenze wähle, die stark neben der tatsächlichen Grenze liegt (die ich nicht kenne), leite ich das Netzwerk fehl. Ein auf diese Weise letztlich falsch trainiertes Netzwerk kann Daten nur schlecht einteilen.” Wählt man zufällig jedoch eine Grenze, der nahe der tatsächlichen liegt, erhält man einen leistungsstarken Algorithmus. Indem die Forscher die Leistung des Algorithmus bestimmten, konnten sie die Grenze eruieren zwischen Quantensystemen, die in ein Gleichgewicht fallen, und solchen, die das nie tun: Die Grenze liegt dort, wo die Sortierleitung des Netzwerks am größten ist.

Die Tauglichkeit ihrer neuen Methode bewiesen die Forscher außerdem mit zwei weiteren Fragestellungen der theoretischen Physik: topologischen Phasenübergängen in eindimensionalen Festkörpern sowie dem Ising-

Die neue Methode lässt sich vereinfacht auch mit einem Gedankenexperiment veranschaulichen, in dem wir rote, rötliche, bläuliche und blaue Kugeln in zwei Gruppen einteilen möchten. Wir nehmen an, dass wir keine Vorstellung davon haben, wie eine solche Einteilung sinnvollerweise aussehen könnte. Nimmt man nun ein neuronales Netzwerk und trainiert es, indem man ihm sagt, die Trennlinie sei irgendwo im roten Bereich, verwirrt man damit das Netzwerk. „Man versucht dem Netzwerk beizubringen, blaue und rötliche Kugeln seien dasselbe, und verlangt von ihm, rote von roten Kugeln zu unterscheiden, was es schlicht nicht zu leisten vermag”, sagt ETH-Professor Huber.

Setzt man die Grenze hingegen im violetten Farbbereich, lernt das Netzwerk einen tatsächlich existierenden Unterschied und sortiert die Kugeln in eine rote und blaue Gruppe. Dass die Trennlinie im violetten Bereich liegen sollte, muss man dabei nicht im vornherein wissen. Indem man die Sortierleistung bei verschiedenen gewählten Grenzen vergleicht, findet man diese Grenze auch ohne Vorwissen.

ETHZ / DE