Mit Spin-Glas und Stochastik zum Maschinellen Lernen

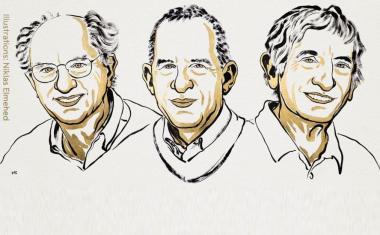

John Hopfield und Geoffrey Hinton erhalten den Physik-Nobelpreis für ihre bahnbrechenden Entdeckungen und Erfindungen, die maschinelles Lernen mit künstlichen neuronalen Netzen ermöglichen.

Alexander Pawlak

Künstliche Intelligenz bzw. Maschinelles Lernen ist mittlerweile allgegenwärtig, doch deren physikalische Grundlagen sind kaum präsent. Das dürfte sich mit dem diesjährigen Physik-Nobelpreis ändern: Er zeichnet zwei Forscher aus, die auf Basis physikalischer Konzepte Methoden entwickelt haben, ohne die das Maschinelle Lernen, das in Alltag, Wirtschaft und Wissenschaft gleichermaßen prägend geworden ist, nicht denkbar wäre.

John Hopfield schuf einen assoziativen Speicher, mit dem sich Bilder und andere Muster in Daten speichern und rekonstruieren lassen. Geoffrey Hinton baute auf Hopfields Arbeiten auf und brachte stochastisches Verhalten ein. Damit ergaben sich Methoden, die selbstständig Eigenschaften in Daten finden konnten, etwa indem sie bestimmte Elemente in Bildern erkennen.

Die Physik war dem 1933 in Chicago geborenen John Hopfield quasi in die Wiege gelegt, denn beide Eltern waren Physiker. Er promovierte 1958 an der Cornell University in Festkörpertheorie. Zuletzt war er Professor für Molekularbiologie an der Princeton University. Dieser Schwenk von der Physik zur Biologie spiegelt sich auch in der Arbeit von 1982 wider, für die Hopfield nun die eine Hälfte des Nobelpreises erhält.

Ausgangspunkt sind sogenannte Spin-Gläser, die Hopfield nutzte, um das Zusammenwirken von Neuronen auf einfachere Weise nachzubilden. Wesentlich ist dabei, jedes Neuron nur zwei Zustände einnehmen kann und mit jedem anderen Neuron verbunden ist. Die Eingangssignale von den anderen Neuronen werden aufsummiert und bewirken ein Umschalten eines Neurons, wenn ein Schwellenwert überschritten wird. Auch wenn das Hopfield-Netzwerk im Vergleich zum Gehirn seriell und ungleich reduzierter arbeitet, eignete es sich mit dem entsprechenden Daten-Input zur Bilderkennung, Signalverarbeitung oder Robotersteuerung.

Der 1947 in Großbritannien geborene Geoffrey Hinton studierte von 1967 bis 1970 Experimentalpsychologie an der Universität Cambridge (England), wechselte jedoch zur Physiologie und Philosophie, bevor er schließlich einen Abschluss in Psychologie machte. Er befasste sich bereits in den 1970er-Jahren mit dem kaum etablierten Gebiet der neuronalen Netze. An der Universität Edinburgh (Schottland) promovierte er 1978 in Informatik mit einer Arbeit zur Datenverabeitung im Sehsystem.

Geoffrey Hinton verwendete Mitte der 1980er-Jahre das Hopfield-Netz als Grundlage für ein neues Netzwerk, das eine andere Methode verwendet: die Boltzmann-Maschine. Dies bezieht sich auf die Boltzmann-Verteilung, in der die Zustände eines Systems von seiner Energie und Temperatur abhängen. Hinton fügte dem Hopfield-Netz eine stochastische Schaltdynamik hinzu sowie Energiemodelle, bei denen die Abweichung von einem Punkt niedriger Energie den Lernerfolg des Netzwerks charakterisierte. Dabei galt es, Methoden weiterzuentwickeln, um unerwünschte lokale Minima zu vermeiden.

Diese Maschine kann lernen, charakteristische Elemente in einer bestimmten Art von Daten zu erkennen. Dafür nutzte Hinton Werkzeuge aus der statistischen Physik. Die Maschine wird trainiert, indem sie mit Beispielen gefüttert wird, die mit hoher Wahrscheinlichkeit auftreten werden, wenn die Maschine betrieben wird. Sie kann etwa dazu dienen, Bilder zu klassifizieren oder neue Beispiele für die Art von Mustern zu erstellen, für die sie trainiert wurde.

Von den grundlegenden Konzepten, die John Hopfield und Geoffrey Hinton vor vier Jahrzehnten entwickelt haben, war es noch ein weiter Weg zu den heute allgegenwärtigen Anwendungen des Maschinellen Lernens bzw. der Künstlichen Intelligenz. Den Durchbruch brachte der Trend zu Big Data, wie er sich in der Wissenschaft vor allem in der Teilchenphysik und der Astronomie zeigte, und der Einsatz von Supercomputer, mit denen sich immer komplexere neuronale Netze realisieren ließen und lassen.

„KI hilft, eine individuelle Krebsbehandlung zu entwickeln, riesige Datenmengen in der Physik zu verarbeiten oder Texte zu übersetzen", sagt Tim Ruhe vom DPG-Arbeitskreis „Physik, moderne Informationstechnologie und Künstliche Intelligenz“, mahnt aber auch: „KI kann auch Fehler machen. Sie ist am Ende nur ein Algorithmus, der umsetzt, was er gelernt hat.“

„Beim diesjährigen Nobelpreis handelt es sich um ein Paradebeispiel einer von der Physik bereits in den 1980er-Jahren entwickelten Methode, die heute unseren ganzen Alltag bereichert“, betont DPG-Präsident Klaus Richter.

Weitere Infos

- Physik-Nobelpreis 2024

- Physik Journal Dossier „Künstliche Intelligenz“

- A. Engel und A. Zippelius: Statistische Mechanik von neuronalen Netzen, Physikalische Blätter 52, 1 (1996), S. 33 PDF

- R. Männer und R.Lange: Rechnen mit Neuronalen Netzen, Physikalische Blätter 50, 5 (1994), S. 445 PDF

- H . Haken: Synergetischer Computer – ein ,,nicht-biologischer" Zugang, Physikalische Blätter 45, 6 (1989), S. 168 PDF

- D. H. Ackley, G. E. Hinton, T. J. Sejnowski, Learning Algorithm for Boltzmann Machines, Cognitive Science 9, 147 (1985) PDF (Wiley Online Library)