Datenflut aus dem All

Systematische Analyse von Archivdaten durch selbstlernende KI-Programme.

Erdbeobachtungssatelliten liefern uns wichtige Daten, um zum Beispiel Veränderungen in Umwelt und Klima schnell zu erfassen oder Gletscherbewegungen oder -schwund zu erkennen. Im Fall von Katastrophen wie Überschwemmungen oder Erdbeben können aktuelle Karten für Rettungskräfte bereitgestellt werden. Doch diese Informationen türmen große Datenberge auf. Die Satelliten des europäischen Copernicus-Programms zählen zu den größten Datenproduzenten weltweit. Sie erzeugen mit ihren hochauflösenden Instrumenten aktuell bereits ein tägliches Volumen von etwa zwanzig Terabyte. Hinzu kommen die Datenschätze von nationalen Missionen wie TerraSAR-X und TanDEM-X sowie zunehmend auch von anderen Quellen wie Internet oder Messstationen. Verarbeitung und Analyse dieser riesigen und heterogenen Datenmengen stehen als „Big Data“-Aufgaben stellvertretend für zukünftige Herausforderung unserer digitalen Gesellschaft. Um diese zu lösen, trafen sich vom 19. bis 21. Februar in München etwa 650 Experten auf der Konferenz „Big Data from Space“.

„Eine immer größere Anzahl von Satelliten, aber auch der Einsatz von neuen Sensoren mit höherer Auflösung liefern uns große Datenmengen – die Auswertung dieser Datenschätze wird zunehmend zu einer technologischen Herausforderung“, sagt Hansjörg Dittus, DLR-Vorstand für Raumfahrtforschung und -technologie. „Daher forscht das DLR verstärkt an effizienten Methoden und Verfahren wie dem maschinellen Lernen, um so aussagekräftige Analysen und Handlungsempfehlungen zur Urbanisierung, zu Veränderungen der Atmosphäre oder auch zur globalen Erwärmung liefern zu können. Zudem plant das DLR, mit einer High Performance Data Analytics Plattform die informationstechnologische Infrastruktur dafür zu schaffen.“

„Für Analysen dieser großen Datenmengen ist ein effizienter Zugriff entscheidend, etwa über Online-Plattformen. Die Entwicklung solcher Zugriffsmöglichkeiten und entsprechender Verarbeitungsmodelle wird daher vom DLR Raumfahrtmanagement gefördert. Neben innovativen wissenschaftlichen Anwendungen ermöglicht dies auch die Entwicklung neuer Geschäftsmodelle im wachsenden Downstream-Sektor innerhalb der Erdbeobachtung", erklärt Walther Pelzer, DLR-Vorstand zuständig für das Raumfahrtmanagement.

Um die Datenberge weiterzuverarbeiten und in Informationen umwandeln zu können, braucht man neue Ideen und Konzepte. Dabei spielt künstliche Intelligenz eine große Rolle, da diese Verfahren gerade bei großen Datenmengen sehr leistungsfähig sind. So erforscht DLR-Wissenschaftlerin Xiaoxiang Zhu an der TU München zum Beispiel den Einsatz solcher Methoden. Zusammen mit ihrem Team entwickelt Zhu explorative Algorithmen aus Signalverarbeitung und der künstlichen Intelligenz, speziell dem maschinellen Lernen, um die Gewinnung globaler Geoinformationen aus Satellitendaten wesentlich zu verbessern und um Durchbrüche in Geo- und Umweltwissenschaften zu erzielen. Einen Schritt weiter geht die Fusion von Petabytes komplementärer georelevanter Datenquellen, von Erdbeobachtungssatelliten bis sozialen Netzwerken, die durch neuartige Data-Science-Algorithmen ermöglicht wird. Die Ergebnisse haben das Potenzial, bisher nicht lösbare große Herausforderungen anzugehen, wie die Erfassung und Kartierung der weltweiten Urbanisierung – eines der wichtigsten Megatrends des globalen Wandels.

Doch nicht nur die Satellitenfernerkundung ist mit dieser Herausforderung konfrontiert. Auch der umgekehrte Blick von der Erde ins All liefert riesige Datenmengen: Teleskope wie zum Beispiel das Square Kilometer Array in Südafrika und Australien oder auch weltraumgebundene ESA-Teleskope wie Gaia und Euclid liefern riesige Datenmengen. Die systematische Analyse von Archivdaten durch selbstlernende KI-Programme bekommt daher auch in der astronomischen Arbeit einen immer höheren Stellenwert.

Erdbeobachtungssatelliten und Teleskope zeigen, dass Methoden aus den Datenwissenschaften und der künstliche Intelligenz unverzichtbar sind. Um diese Massen an Daten handhaben und auswerten zu können, braucht man geeignete Speicher- und geschickte Zugriffsmöglichkeiten. Für interessierte Nutzer ist letztlich nur der Zugang entscheidend – heutzutage meist in Form eines Online-Portals wie zum Beispiel der Plattform „Copernicus Data and Exploitation Platform – Deutschland“ des DLR-Raumfahrtmanagements. Sie können dort auf alle Daten zugreifen und direkt vor Ort weiterverarbeiten. Es steht somit online eine komfortable Arbeitsumgebung für die Satellitendaten, die im Copernicus-Programm kostenfrei bereitgestellt werden, zur Verfügung. Das spart lokalen Speicherplatz und Rechnerkapazitäten bei den Anwendern.

Aber auch die Datenportale selbst sind Gegenstand der Forschung. Wie sieht die ideale Plattform aus und welche Suchoptionen sollten dem Nutzer zur Verfügung stehen? Nach dem Vorbild von Internetsuchmaschinen sollen Bilder entfernter Planeten oder von der Erdoberfläche ganz einfach anhand von Informationen gefunden werden. „Auf welchem Himmelskörper ist wahrscheinlich Wasser vorhanden?" Oder: „Welche Gebiete sind in Deutschland im Sommer besonders von Dürre betroffen?“ Solche Suchanfragen sollen modernen Portalen die richtigen Datensätze als Antwort liefern. Von hoher Bedeutung ist auch der langfristige Bestand dieser globalen Informationen. Ähnlich einer Bibliothek muss sichergestellt werden, dass Satellitendaten über einen langen Zeitraum erhalten bleiben, gefunden werden können und abrufbar sind. Das geschieht etwa im Deutschen Satellitendatenarchiv des Earth Observation Centers am DLR in Oberpfaffenhofen.

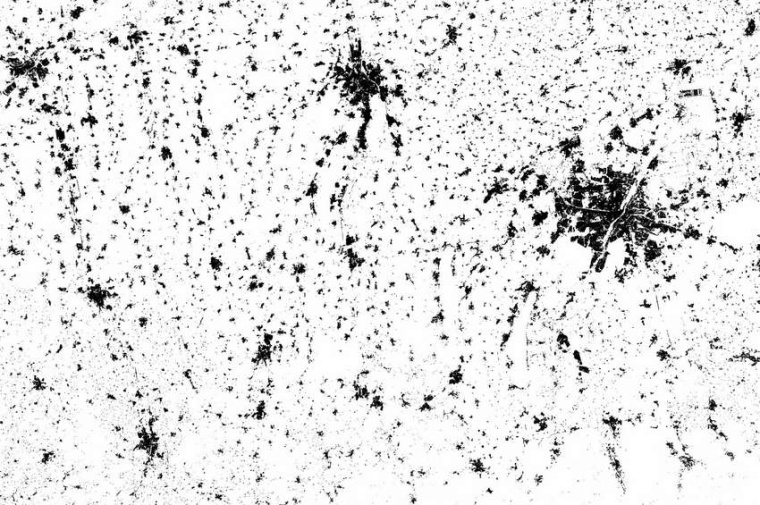

Ein großer Vorteil der modernen Erdbeobachtung sind Zeitreihen. Vergleicht man zum Beispiel die globale Gletscherdynamik, lassen sich wertvolle Informationen zum Klimawandel, zur Veränderung des Meerwasserspiegels und für den regionalen Wasserhaushalt gewinnen. Doch die umfangreichen Zeitreihen gehen mit riesigen Datenmengen einher, die sich kaum mehr bewegen und verarbeiten lassen. Produkte des DLR wie der World Settlement Footprint, eine globale hochauflösende Kartierung des Städtewachstums über die letzten dreißig Jahre, lassen sich nur mehr durch sehr leistungsstarke Rechenzentren und automatisierte Auswertungsverfahren realisieren. Vor wenigen Jahren undenkbar, zeigt dieses Beispiel das Potenzial, dass die heute verfügbaren großen Datenmengen in Kombination mit maschinellen Verfahren bieten. Außerdem arbeiten Wissenschaftler an einem Werkzeug, das die Informationen aus Zeitreihenmessungen automatisch abgleicht und so diesen „Flaschenhals“ umgeht. So können Zeit und Speicherplatz bei der Auswertung eingespart werden. Doch nicht nur Erdbeobachtungsexperten sollen Satelliteninformationen künftig zur Verfügung stehen. Auch Laien sollen in den Genuss dieser Produkte kommen. Das ist momentan allerdings noch sehr schwierig, da bislang weitgehend unbearbeitete Daten zur Verfügung stehen. IT-Experten wollen das nun ändern und analysefertige Daten und Services bereitstellen.

DLR / RK

Weitere Infos