Mit allem rechnen

Verbundprojekt für innovative computergestützte Verarbeitungsmethoden

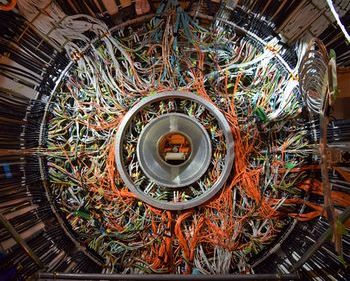

Was sind die fundamentalen Bausteine der Natur? Wie ist das Universum entstanden und wie hat es sich entwickelt? Diesen grundlegenden Fragen gehen Wissenschaftler mit sehr unterschiedlichen Methoden nach. Am Large Hadron Collider am CERN und beim Belle II-Experiment in Japan etwa suchen sie nach neuen elementaren Teilchen in Proton-Proton- beziehungsweise Elektron-Positron-Kollisionen. Am FAIR-Beschleuniger wollen die Forscher in wenigen Jahren komprimierte Neutronenstern-Materie im Labor herstellen, die Quelle der schweren Elemente im Kosmos. Am Pierre-Auger-Observatorium in Argentinien erlangen die Wissenschaftler durch den Nachweis hochenergetischer kosmischer Strahlung Erkenntnisse über astrophysikalische und kosmologische Prozesse.

Trotz unterschiedlicher Methoden und wissenschaftlicher Fragestellungen verbindet die Forscher eine Herausforderung. Die zunehmend höhere Auflösung der Messinstrumente und die Leistungssteigerung der Beschleuniger versprechen zwar neue wissenschaftliche Erkenntnisse, allerdings steigen damit auch die Datenmengen rasant an. Schon jetzt fallen beispielsweise bei den Experimenten am CERN etwa fünfzig Petabyte Daten jährlich an. „In den kommenden zehn Jahren erwarten wir aufgrund der Weiterentwicklungen von Detektoren und Beschleunigern eine Zunahme der Datenmengen um den Faktor 50“, sagt Thomas Kuhr von der Uni München.

Neue Entwicklungen in der Speicher- und Prozessortechnologie können dieses Wachstum an Speicherbedarf bei Weitem nicht ausgleichen. Um auch weiterhin Forschungsdaten analysieren zu können, braucht es daher künftig komplett neue Rechenkonzepte. Um diese zu entwickeln, haben sich Wissenschaftler aus der Teilchenphysik, der Hadronen- und Kernphysik sowie der Astroteilchenphysik jetzt zu einem experiment- und fachübergreifenden Verbund zusammengeschlossen.

Das Bundesministerium für Bildung und Forschung fördert diesen Verbund mit dem Namen „Innovative Digitale Technologien für die Erforschung von Universum und Materie“ mit insgesamt 3,6 Millionen Euro über die nächsten drei Jahre. Beteiligt sind Teams der Universitäten Aachen, Bonn, Erlangen-Nürnberg, Frankfurt am Main, Freiburg, Göttingen, Hamburg, Mainz, München, Münster, Wuppertal und des Karlsruher Instituts für Technologie sowie der assoziierten Partner DESY, CERN, Forschungszentrum Jülich, Grid Computing Centre Karlsruhe, GSI Helmholtzzentrum für Schwerionenforschung. Die Verbundkoordination übernimmt Kuhr.

Innerhalb der nächsten drei Jahre entwickelt und testet der Verbund neue Computing-Systeme. Ein vielversprechender Ansatz ist dabei der Einsatz von Virtualisierungs-Technologien, um bisher unzugängliche Ressourcen zu erschließen. Auch an die Nutzung von neuen Prozessor-Architekturen, die zum Beispiel in Grafikkarten eingesetzt werden und eine bessere Energieeffizienz versprechen, denken die Wissenschaftler. Eine wichtige Säule sehen die Forscher in der Entwicklung verbesserter Algorithmen und dem Einsatz von künstlicher Intelligenz für Big-Data-Analysen. Dabei sollen innovative Methoden des maschinellen Lernens eine wichtige Rolle spielen.

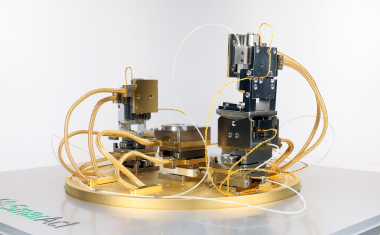

„Die riesigen Datenmengen sind für uns eine große Herausforderung. Innovative digitale Methoden sind künftig unabdingbar, um die Grundlagenforschung entscheidend voranzubringen“, sagt Kuhr. Aber nicht nur die physikalische Forschung steht vor der digitalen Herausforderung. „Auch andere Wissenschaftsbereiche benötigen über kurz oder lang leistungsstarke Rechenumgebungen und werden von den neuen Kompetenzen profitieren.“ Das Verbundprojekt bietet den beteiligten Nachwuchswissenschaftlern eine hervorragende Gelegenheit, sich ein umfassendes Wissen in neuen Computing-Technologien anzueignen. Damit sind sie bestens darauf vorbereitet, führende Positionen in Wissenschaft oder Wirtschaft zu besetzen, um den digitalen Wandel voranzutreiben. Neben der Koordination übernimmt die Uni München im Verbund die Aufgabe, Simulationsrechnungen, zunächst am Beispiel des Belle II-Experiments, durch den Einsatz tiefer neuronaler Netze deutlich zu beschleunigen. Außerdem entwickeln Wissenschaftler der Uni München neue Methoden zum effizienten Zugriff auf riesige Datenmengen über große Entfernungen.