Eisen-Palladium: Aminosäuresequenz RGD haftet stärker als gedacht

Determined binding energy of the molecule to the magnetic shape memory alloy with density functional theory-based computer simulations.

• 9/2015 • Seite 41

• 9/2015 • Seite 41Quantum fluctuations played a crucial role in the formation of the structure of our universe.

On March 21, 2013 something very remarkable happened. The Planck science team released a highly precise photograph of our universe when it was only few hundred thousand years old. This photograph is so detailed that it shows some major features that the universe acquired only 10–35 seconds after creation. Most strikingly, the observed nontrivial features in the portrait of such a young universe came in exact agreement with what had been predicted by the theorists more than thirty years ago, long before the experiment was carried out. Without any exaggeration one can say that by now it is experimentally proven that quantum physics, which is normally considered to be relevant in atomic and smaller scales, also played the crucial role in determining the structure of the whole universe, including the galaxies, stars and planets.

Of course scientists and philosophers have always been interested in the origin of our universe. However, cosmology only became a natural science less than a hundred years ago. It was not until 1923 that the American astronomer Edwin Hubble was able to resolve individual stars in the Andromeda Nebula and to conclude that for sure it is located outside of our own galaxy. This was the beginning of extragalactic astronomy. Today it is well established that there are about a hundred billion galaxies in our universe. Thus, the stars form galaxies with a size of about a hundred thousand light years. Moreover, the distance between neighboring galaxies is a few million light years. Observing the spectral lines of the galaxies, Hubble discovered that they are slightly redshifted. He interpreted this as a Doppler shift due to the relative motion of the other galaxies, which try to escape from us. Hubble also found that the spectral lines of galaxies further away show higher redshift. This means that they are escaping with higher velocities, proportional to the distance (v→ = H r→) and thus the universe expands. This discovery was the beginning of scientific cosmology.

With Hubble’s discovery it became clear that our universe is evolving as a whole. This did not come as a big surprise! In 1922 the Russian physicist Alexander Friedman had found that the generic solutions of the Einstein’s equations describe either an expanding or a contracting Universe. Assuming that the total mass of the universe is about a hundred billion times larger than the mass of our galaxy, Friedman was even able to conclude that the universe must be about 10 billion years old. Thus, Hubble’s discovery can be considered as a brilliant confirmation of the theoretical prediction by Friedman. The most important conclusion from Hubble’s discovery was that the universe was created about several billions years ago. This extremely important discovery remained for many years the single experimentally established fact in cosmology. Only after more than thirty years the other piece of the puzzle was discovered. ...

Thin liquid films have properties that can be different from the bulk material. We have studied freely suspended films of polyelectrolyte solutions, that means films with two liquid-air surfaces. We were able to show that the forces between surfaces are oscillatory, revealing stratification, i. e. a structuring in layers of thickness equal to the polymer network mesh size. The stratification kinetics reveal interesting differences when the surface conditions are changed.

Determined binding energy of the molecule to the magnetic shape memory alloy with density functional theory-based computer simulations.

Metamaterials have become one of the hottest fields of photonics since the pioneering work of John Pendry on negative refractive index, invisibility cloaking, and perfect lensing. For practical applications, three-dimensional metamaterials are required. Here, coupling effects between individual constituents play a dominant role for the optical and electronic properties. Metamaterials can offer both electric and magnetic responses at optical frequencies. Hence, electric as well as magnetic dipolar and higher-order multipolar coupling are the essential mechanisms. The intricate interplay between different coupling effects in a plasmon hybridization picture provides a hands-on tool to intuitively understand the evolution from molecule-like states to solid-state-like bands.

A. Zee: Group Theory in a Nutshell for Physicists, Princeton University Press 2016, 632 S., geb., 90 $, ISBN: 9780691162690

During the last years there has been a rapidly growing interest in the field of cold molecules. This has obviously been inspired by the spectacular successes in the closely related field of cold atoms, which have recently been recognized by the award of the 2001 Nobel Prize in Physics to Cornell, Ketterle, and Wieman for ''the achievement of Bose-Einstein condensation in dilute gases of alkali atoms, and for early fundamental studies of the properties of the condensates.'' But molecules have much more to offer than simply extending the experiments already performed with atoms to more complex species.

Free Access

Titelbild: Vakuum in Forschung und Praxis 2/2024

Free Access

Pages: 3

Inhalt: Vakuum in Forschung und Praxis 2/2024

Pages: 4-5

News: Vakuum in Forschung und Praxis 2/2024

Pages: 6-11

Forschung: Vakuum in Forschung und Praxis 2/2024

Pages: 12-21

Personen: Vakuum in Forschung und Praxis 2/2024

Pages: 22-23

Oliver Gerberding, Jens Grundmann, René Wutzler, Artem Basalaev

Pages: 24-28

Seit der LIGO-Kollaboration Ende 2015 der erste direkte Nachweis gravitationsbedingter Ausbreitungen von Raumzeit-Störungen gelang, steht ein weiteres Werkzeug zur Beobachtung des Weltalls zur Verfügung. In verschiedensten Projekten feilt man nun an der Verfeinerung der Messtechnik, um aus möglichst weiter Entfernung ausgesendete Signale untersuchen und so noch weiter in die Vergangenheit des Weltalls schauen zu können. Neben exzellenten Laser-Interferometern, deren Funktionsweise hier kurz vorgestellt wird, braucht es zuverlässige Vakuumtechnik für den Erfolg dieser Messungen.

Was beim Aufbau einer solchen Vakuumanlage zu berücksichtigen ist, und welche Pumpentypen dabei zum Einsatz kommen, wird hier anhand des Projekts „VATIGrav” beschrieben.

Open Access

Vacuum Guerikianum - Guericke-Vakuum: Von der Erfindung der Vakuumpumpe zur weltweiten Anwendung

Pages: 29-35

Otto von Guericke hat die Vakuumpumpe etwa 1649 in Magdeburg erfunden und weiterentwickelt. Damit begründete er die Vakuumtechnik, deren weltweite Anwendung gegenwärtig rasant wächst. Das Guericke-Vakuum ist der Druckbereich von Atmosphärendruck bis zu dem Vakuumdruck, den Otto von Guericke in seinen Experimenten minimal erreicht hat bzw. erreicht haben könnte. Der Vakuumdruck wurde von Guericke nicht gemessen. Aber mit seinen Versuchsbedingungen: 1. Wasser als Dichtungsflüssigkeit, 2. Glasrezipient und 3. Beobachtung von Wasserdampf beim Abpumpen, kann der unterste Vakuumenddruck anhand der Sättigungsdampfdruckkurve von Wasser rekonstruiert werden. Das Ergebnis ist abhängig von der Temperatur. Wie genau auch, das Guericke-Vakuum entspricht dem Grobvakuum-Bereich der Vakuumtechnik. In Würdigung Guerickes genialem Wirken zur Begründung und Entwicklung der Vakuumtechnik nennen wir das Grobvakuum auch Guericke-Vakuum, welches den Druckbereich von Normaldruck bis 1 hPa umfasst.

Pages: 36-39

Die Umwandlung von Licht in Ladungsträger und deren Transport zu elektrischen Kontakten sind die Hauptaufgaben organischer Halbleiter in Bauelementen der Informationstechnologie und Photovoltaik. Doch bislang ist wenig über die gegenseitige Beeinflussung beider Prozesse bekannt. Die zeitaufgelöste Photoelektronen-Spektroskopie mit ultrakurzen Pulsen im extremen UV-Bereich liefert Einblicke in die Kopplung von optischen und Transporteigenschaften in organischen Halbleitern.

Holger Hoche, Thomas Ulrich, Peter Kaestner, Matthias Oechsner

Pages: 40-44

A novel, monolithic DC-magnetron sputtered TiN+MgGd coating, only 3to5 μm thick, effectively protects steel substrates from corrosion. This achievement is due to alloying of TiN with MgGd, which not only maintains the renowned wear resistance of TiN coatings, but potentially improves it through optimized deposition parameters.

The key to the enhanced corrosion resistance lies in the addition of magnesium (Mg) and gadolinium (Gd). It reduces the coating's free corrosion potential, thereby mitigating the driving force for galvanic corrosion between coating and substrate. Moreover, at specific Mg to Gd ratios, a cathodic protection effect can be observed. Crucially, the presence of Gd is essential for this performance. It imparts hydrophobicity to the coating surface, reinforces a passivating layer and significantly enhances defect tolerance.

This discovery paves the way for a sustainable alternative to electroplated chromium or combined electroplating and PVD, offering superior corrosion protection with minimal coating thickness.

Open Access

DVG: Vakuum in Forschung und Praxis 2/2024

Pages: 45-46

Termine: Vakuum in Forschung und Praxis 2/2024

Pages: 47

Bezugsquellen: Vakuum in Forschung und Praxis 2/2024

Pages: 48-50

Index/Impressum: Vakuum in Forschung und Praxis 2/2024

Pages: 51

The concept of quarks and leptons as the basis for the understanding of the fundamental structure of matter and forces was established in the late sixties and early seventies, culminating in the discovery of the J/ψ particle in the so-called ''November revolution'' of 1974. This particle was subsequently interpreted as the bound state of a new heavy quark, the charm quark, and its antiparticle. The subsequent discovery of the heavy lepton, the τ, and the even heavier bottom and top quarks completed the picture of the fermion content of the Standard Model of particle physics.

• 9/2023 • Seite 65 • DPG-Mitglieder

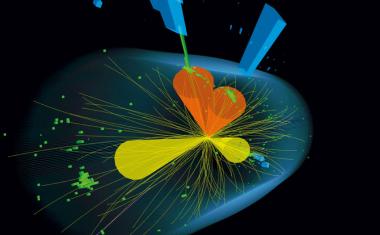

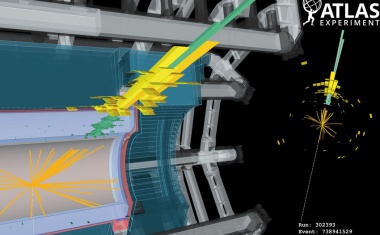

• 9/2023 • Seite 65 • DPG-MitgliederPrecise and fine-grained measurements of the Higgs boson are continuously improved.

The Large Hadron Collider is a 27 km-long circular particle collider which has been in operation since 2010 at CERN. At the Large Hadron Collider, protons collide at a record-breaking centre-of-mass energy of up to 13.6 TeV. Four large experiments are placed around the ring at the intersection points of the proton beams: ATLAS, CMS, LHCb, and ALICE detect the products of the resulting collisions. The study of these data helps to improve our understanding of the universe.

In July 2012, the ATLAS and CMS collaborations announced the discovery of a new particle with a mass of around 125 GeV/c2 [1 – 3]: the Higgs boson, a particle predicted in the 1960s which is responsible for generating the masses of other elementary particles. The Standard Model of particle physics describes the building blocks of everything around us. Matter consists of fermions: quarks and leptons which exist in three generations. The interactions between these particles are mediated by ‚force carriers‘: the bosons. The discovery of the Higgs boson completed a major missing piece of the Standard Model.

One of the reasons, it took nearly half a century to find the Higgs boson is that its mass was not predicted by the Standard Model. Therefore, physicists had to search a wide range of masses. Furthermore, the Higgs boson can decay to a range of other elementary particles – and the rate of a particular decay channel depends on the mass of the Higgs boson. Thus, many different final states had to be investigated. With a mass of 125 GeV/c2, the Higgs boson might decay into pairs of bosons (WW, ZZ, γγ) or pairs of fermions such as bottom quarks and tau leptons. In addition to a range of decay channels, there are several ways to produce the Higgs boson at the Large Hadron Collider (LHC): the dominant production mechanism with 87 % is the fusion of two gluons, followed by the fusion of vector bosons (W or Z boson), the production in association with a vector boson, and with a pair of top quarks. (...)

• 10/2014 • Seite 25

• 10/2014 • Seite 25Ob Automobile, Flugzeuge, Kerntechnik, Daten oder Informationen – überall kommt es auf die Sicherheit an. Diese zu gewährleisten, ist auch Aufgabe von Physikern.

Sicher sollen sie sein – das gilt für Kernkraftwerke, Autos, Flugzeuge und Daten gleichermaßen. Beim Ausfall technischer Komponenten kann es um Leib und Leben gehen, beim Verlust von Daten um hohen wirtschaftlichen Schaden...

Defekte Zündschlösser, klemmende Gaspedale oder nicht funktionierende Airbags – immer wieder geraten Automobilhersteller mit Negativschlagzeilen in die Presse. Die Zahl der Rückrufe steigt beständig, und 2014 hat sich bereits jetzt zu einem traurigen Rekordjahr entwickelt: Bis Juni wurden laut einer Studie des Center of Automotive Management in Bergisch-Gladbach auf dem US-Markt 37,2 Millionen Fahrzeuge zurückgerufen, 25 Millionen allein von General Motors! Für GM bedeutet das einen riesigen Imageverlust und einen Gewinneinbruch von fast 90 Prozent im ersten Quartal – mindestens zwölf Menschen haben das defekte Zündschloss bei GM sogar mit dem Leben bezahlt.

Bei solchen Vorfällen gilt es für die Automobilhersteller, möglichst schnell die Ursache zu finden. Häufig holen sie sich dafür Hilfe von außen, beispielsweise von der Schweizer Société Générale de Surveillance SGS – dem weltweit führenden Unternehmen im Bereich Testen, Inspizieren und Zertifizieren. SGS arbeitet für Kunden aus der Automobilindustrie, Luft- und Raumfahrt, Medizintechnik oder Pharmaindustrie sowie für Versicherungen, Gutachter und Gerichte. Den Standort in Dortmund leitet der Physiker Olaf Günnewig. Die Themen „Sicherheit“ und „Prüfen“ ziehen sich durch sein gesamtes Berufsleben. Dabei war es der Zufall, der ihn damit in Kontakt gebracht hat. „Ich habe mich etwas spät um ein Thema für meine Diplomarbeit gekümmert und bin eher zufällig in der Computertomografie gelandet“, erinnert er sich. In der Promotion hat er damit menschliche Knochenproben untersucht. Bei seinem ersten Arbeitgeber hat der 49-jährige Physiker industrielle Computertomografen entwickelt. Im Jahr 2000 ist er beim Institut Fresenius gelandet. Das Labor verbinden viele mit Wasser- und Lebensmittelanalysen oder dem Qualitätssiegel auf dem Nutellaglas. Es führt aber auch Untersuchungen an technischen Komponenten durch. Seit 2004 ist das Institut eine Tochtergesellschaft der SGS...

In massive stars a sequence of fusion reactions takes place, starting from the fusion of hydrogen to helium and proceeding through carbon, neon, oxygen, silicon up to iron. When the iron core becomes unstable and collapses to produce a neutron star, a core-collapse supernova explosion occurs. Since the energy liberated by the collapse is emitted mainly in neutrinos of all flavors, such a supernova is one of the few astrophysical events where the weak interaction produces effects of macroscopic scale. Whereas most of the nuclei heavier than iron are produced by neutron captures, the origin of the neutron-deficient isotopes Molybdenum and Ruthenium in our solar system has remained mysterious.

• 9/2014 • Seite 37

• 9/2014 • Seite 37Life as a problem in nonequilibrium statistical mechanics

We review some problems in nonequilibrium physics from the point of view of statistical physics and differentiable dynamics. Specifically, we discuss the mathematical difficulties which inherently underlie applications to heat transport, to hydrodynamic turbulence, and to the study of life. The microscopic dynamics of transport phenomena (in particular heat transport) is necessarily non hyperbolic, which explains why it is a difficult problem. The 3D turbulent energy cascade can be analyzed formally as a heat flow, and experimental intermittency data indicate that this requires discussing a Hamiltonian system with 104 degrees of freedom. Life is a nonequilibrium statistical physics phenomenon which involves chemical reactions and not just transport. Considering life as a problem in nonequilibrium statistical mechanics at least shows how complex and difficult the study of nonequilibrium can be.

The aim of nonequilibrium statistical mechanics is to understand the properties of matter outside of equilibrium, starting from microscopic dynamics. At this time nonequilibrium statistical mechanics of transport phenomena close to equilibrium is a well-developed physical theory (due to the work of Onsager, Green, Kubo, etc. in the 1950’s, see for instance [1]). Away from this area, the theory of nonequilibrium is a program, or a variety of programs, rather than a theory. Here I shall make a choice, and describe an approach starting with classical Hamiltonian microscopic dynamics. From my point of view this approach has the interest that it uses nontrivial recent results in the theory of smooth dynamical systems, and that it sheds light on interesting physical phenomena: heat transport, hydrodynamic turbulence, and life. (...)

T. Eguchi, M.Y. Han (Hrsg.): Nambu – A Foreseller of Modern Physics, World Scientific, Singapur 2014, £ 23,00, ISBN 9789814583053

• 9/2020 • Seite 51 • DPG-Mitglieder

• 9/2020 • Seite 51 • DPG-MitgliederHow to study Dark Matter from high-energy collisions and what is known so far.

In the last century, high-energy physics has made incredible steps forward towards the comprehension of the nature of our universe, its matter content and interactions. This development culminated with the discovery of a Higgs boson by the Large Hadron Collider experiments completing the last piece of the particle puzzle. Nevertheless, the Standard Model of particle physics cannot explain the existence of Dark Matter yet. Uncovering the identity of this kind of matter is a central and grand challenge for both fundamental physics and astronomy.

The nature and properties of Dark Matter are largely unknown: proposed candidates span tens of orders of magnitude in mass, ranging from elementary particles infinitesimally lighter than electrons to massive primordial black holes [1]. One of the most compelling candidates is a new class of subatomic particles: weakly interacting massive particles (WIMPs). WIMPs represent the current paradigm for searches for Dark Matter particles. They are up to a hundred times heavier than protons and only interact weakly with ordinary particles. Presumably, they were produced in the early universe.

To understand Dark Matter is a multi-disciplinary effort involving different and complementary experimental techniques. Direct searches rely on the distribution of Dark Matter in the Milky Way exposing the Earth to a constant high flux of Dark Matter particles. Direct detection experiments aim to detect their elastic scattering off nuclei in specialised low background detectors. Indirect searches are based on the annihilations or decays of Dark Matter particles in astrophysical systems. Various ground and space-based specialised instruments monitor the frequency of such events. Collisions in high-energy particle accelerators like the Large Hadron Collider (LHC) might create particles which were present in the early universe. (...)

• 9/2020 • Seite 32 • DPG-Mitglieder

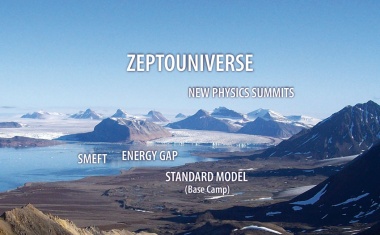

• 9/2020 • Seite 32 • DPG-MitgliederFlavour experiments promise insights into energy scales as high as 200 TeV and distances as small as 10−21 meter and offer the chance to identify New Physics.

The Large Hadron Collider (LHC) at CERN will directly probe distance scales as short as 10–19 m, corresponding to energy scales at the level of a few TeV. Presently, higher resolution can only be achieved with the help of quantum fluctuations caused by new particles and new forces that act at very short distance scales and modify the predictions of the Standard Model of particle physics for very rare processes. In this context, weak decays of mesons and leptons play the prominent role besides the transitions between particles and antiparticles in which flavours of quarks and leptons are changed. In this manner, information about the Zeptouniverse corresponding to energy scales as high as 200 TeV or distances as small as 10–21 m can be obtained.

The year 1676 was very important for humanity, because Antoni van Leeuwenhoek discovered the empire of bacteria. He called these small creatures animalcula (small animals). His discovery was a milestone in our civilization for at least two reasons: He discovered creatures invisible to us which have been killing humans for thousands of years, often responsible for millions of deaths in one year. While Antoni van Leeuwenhoek did not know that bacteria could be dangerous for humans, his followers like Louis Pasteur, Robert Koch and other „microbe hunters“ realized the danger coming from these tiny creatures and also developed weapons against this empire [1].

Van Leeuwenhoek was the first human who looked at short distance scales invisible to us and discovered thereby a new underground world. At that time, researchers looked mainly at large distances, discovering new planets and finding laws, such as the Kepler laws which Isaac Newton was able to derive from his mechanics. (...)

Free Access

Indranil Banerjee, Andreas Schopphoff, Shaun Hughes, Robert Pearce, Sergei Nasluzov

The tritium compatible Roots pump Okta 1500 (Pfeiffer Vacuum) is designed for pumping light gas species consisting of diluted radioactive gas, especially tritium mixed with other hydrogen isotopes and helium. Therefore, the pump is constructed of stainless steel and equipped with a special gas lubricated mechanical seal.

The series of experiments presented in this work include the evaluation of the performance and an integrity check of the glide ring seal as well as the determination of the light gas pumping performance at low pressure. Those qualifications are needed for efficient embedding of the pump in the International Thermonuclear Experimental Fusion Reactor (ITER) project. As a nuclear facility (Installation Nucléaire de Base, INB) ITER is operated in accordance with the French nuclear safety regulations (INB guidelines) that demand qualification and integrity of the tritium bearing equipment to maintain performance and confinement of active gases at every stages via design, testing, commissioning, operation and surveillance. The experimental methodologies and findings are important to advocate the qualification of the pump for the purpose of radioactive light gas pumping as a roughing pump to back Torus high vacuum cryogenic pump.

In diesem Artikel werden mehrere Prinzipien zur Analyse von Gasen betrachtet. Dabei handelt es sich sowohl um universelle, als auch binäre Ansätze. Besonderes Augenmerk wird dabei auf die binäre Gasanalyse auf Basis der Schallgeschwindigkeitsmessung mit dem SRS BGA244 gelegt, dessen Funktionsprinzip ebenfalls erläutert wird. Die Fähigkeiten und Vorteile dieses Messprinzips werden anhand von Beispielen in Zusammenhang mit Wasserstoff als Kühlmittel von Elektrizitätsgeneratoren sowie in der Dotierung bei der Halbleiterherstellung aufgezeigt. Messergebnisse bestätigen die Zuverlässigkeit und Genauigkeit des binären Gasanalysesystems.

Aleksey Burmistrov, Alexey Raykov, Aleksandr Isaev, Sergey Salikeev, E. Kapustin, Marina Fomina

In this paper influence of rotor profile type of Roots vacuum pumps on backward leakage through channels of rotor mechanism and pumping speed is considered.

Elliptical, involute, and circular profiles are widely used. Backward leakage through channels of rotor mechanism with different rotor profiles is determined from conductance which was calculated by angular coefficients method for free molecular flow regime at different rotors rotating angles. It is shown that backward leakage is maximal at rotors rotating angles 25–45° due to maximal inter-rotor channel opening for gas flow and is minimal at 0°. Elliptical rotor profile provides minimal backward leakage over one revolution.

Numerical modeling of Roots pump working process was carried out on the basis of CFD ANSYS-CFX complex by dynamic meshing method. SST turbulence model was used for calculations. It is confirmed that maximal pumping speed is provided by Roots pump with elliptical rotor profile.

Nowadays, there is a great interest in designing and fabricating thin films with unique morphologies to improve the surface properties for various applications. In this regard, atomic force microscopy (AFM) is widely used to investigate the surface morphology of thin films. The high spatial and vertical resolution makes AFM capable of extracting surface micro-roughness information precisely. In this study, films were deposited on different substrates using the RF-PECVD method. The morphological properties were studied by AFM analysis according to ISO 25178-2: 2012.The results of analyzing the AFM data demonstrate that a copper substrate is a good option for the fabricated silver film in this study, and it is a relatively ideal surface in terms of fractality.

The magnetic moment or "spin" of an individual electron is an unimaginably tiny quantity. It is so small that it was only during the past few years that it became possible to detect single spins in solids, manipulate them and directly study their behaviour. Special spin memory devices have been developed that enable the optical generation of single charges in semiconductor artificial atoms. Remarkably, the spin of these charges can be programmed by the polarisation of the photons used to create them. Localising spins in such nanostructures dramatically suppresses their coupling to the outside world, making them potentially useful for quantum information processing.

• 6/2018 • Seite 57

• 6/2018 • Seite 57Zum 100. Geburtstag des Physik-Nobelpreisträgers Richard P. Feynman (1918 – 1988)

Um keinen anderen amerikanischen Physiker hat sich ein ähnlicher Geniekult entwickelt wie um Richard Feynman. Dazu haben sein öffentliches Auftreten und seine autobiografischen Schriften sicher wesentlich beigetragen. Feynman war ein brillanter Wissenschaftler und eine originelle Persönlichkeit, aber kein „einsames“ Genie. Eine historische Perspektive zeigt, dass er mit seinen physikalischen Arbeiten und seinem Denkstil in der Community verankert war.

Im Juni 1947 traf sich auf Shelter Island, einer kleinen Insel vor New York, ein exklusiver Kreis von zwei Dutzend der führenden Physiker in den USA, unter ihnen John von Neumann, J. Robert Oppenheimer, John A. Wheeler und der aufstrebende Richard Feynman. In lockerer Atmosphäre diskutierten sie die neuesten Entdeckungen aus der Elementarteilchenphysik und der Quantenelektrodynamik. Diese beiden Teilbereiche entwickelten sich zu zwei der Hauptforschungsrichtungen der Nachkriegsphysik der USA.

In dieser Periode veränderte sich der pragmatische Forschungsstil der 1920er-Jahre, demzufolge es die Aufgabe des Physikers nur war, messbare Größen vorherzusagen. Wie der Weg dorthin genau aussah, spielte dagegen keine Rolle, ebenso wenig philosophische Reflexionen. Dieser Stil verband sich nach Kriegsende mit der Arbeitsweise junger theoretischer Physiker, die eng mit Experimentalphysikern kooperierten und deren Bedürfnisse genau kannten.

Insbesondere in der Teilchenphysik und der Militärforschung verschmolz die Arbeit von Experimentatoren und Theoretikern so, dass sich der alte pragmatische Stil zu einem „pragmatic, utilitarian, instrumental style“ weiterentwickelte, der von den experimentellen Möglichkeiten der Instrumente der Großforschung bestimmt war.2) Wie stark Richard Feynman an diese Community und ihren Stil gebunden war, soll im Folgenden untersucht werden. (...)

How do interfaces influence the chemical and physical properties of a material? Despite the large amount of knowledge that has been uncovered in the past decades for (human-engineered) flat interfaces, the story about molecular properties of interfaces of soft matter systems, such as colloids, emulsion, vesicles, cells and other nanoscopic structures is yet to be told. This is due to the surrounding medium that forms an often impenetrable barrier. Thanks to new developments in the field of nonlinear optics, this is about to change.

We discuss the partonic structure of the proton, and outline how the parton densities may be determined. We use them to predict the event rates of various processes which may be observed at the forthcoming Large Hadron Collider at CERN. We briefly discuss how to observe a „light" Higgs boson (of mass less than 140 GeV), and emphasize the advantages of an exclusive Higgs signal.

Die Sonderausgaben „Best of“ und „Physics' Best“ präsentieren kompakt und übersichtlich neue Produkte und ihre Anwendungen. Sie ergänzen die regulären Hefte des „Physik Journal“, indem sie Anwendern und Unternehmen ein zusätzliches Forum bieten. Darin finden sich nicht nur hilfreiche Produktinformationen, sondern auch ausführliche Anwenderberichte aus einem breiten Themenspektrum im Rahmen der Rubriken Optik & Photonik, Laser, Messtechnik, Nanotechnologie, Vakuumtechnik und Software.

• 6/2023 • Seite 31 • DPG-Mitglieder

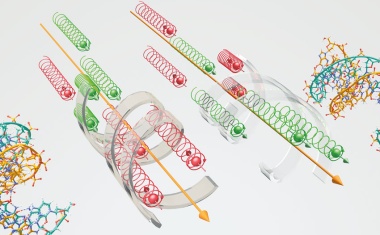

• 6/2023 • Seite 31 • DPG-MitgliederSpinselektive Transmission von Elektronen in chiralen Systemen

Chiralität bedeutet, dass Teilchen nicht mit ihrem Spiegelbild zur Deckung zu bringen sind. Chirale Systeme, wie oligo-DNA-Moleküle oder Helicen, weisen eine spinabhängige Photoelektronen-Transmission auf und können somit als eine Art Spinfilter wirken. Damit eignen sie sich etwa für das Design organischer spintronischer Bauteile oder liefern wichtige Erkenntnisse über den Elektronentransfer in Biomolekülen.

Elektronen besitzen neben ihrer Ladung ein intrinsisches magnetisches Moment, das 1922 im Stern-Gerlach-Experiment nachgewiesen wurde. Dieses lässt sich auf eine quantenmechanische Eigenschaft des Elektrons zurückführen: Den Spin, der formal einem Eigendrehimpuls entspricht. Er ist in zwei Werte sz = ± ħ/2 quantisiert. Der Spinvektor kann in alle drei Raumrichtungen zeigen; seine Projektion auf eine beliebig gewählte Quantisierungsachse nimmt jedoch immer den positiven (spin up, parallel) oder den negativen Wert (spin down, antiparallel) an. 1928 zeigte Paul Dirac, dass ein solcher Freiheitsgrad direkt aus der relativistischen Beschreibung der Elektronenbewegung im Atom folgt. Der Spin von Elektronen koppelt mit dem Bahndrehimpuls im Atom oder Molekül; die Kopplung wächst sehr stark mit der Kernladungszahl.

Effekte, bei denen die Ausrichtung des Spins eine Rolle spielt, sind also eher nicht bei organischen Molekülen zu erwarten, die hauptsächlich aus leichten Atomen wie Kohlenstoff und Wasserstoff bestehen. Dennoch weisen in jüngster Zeit viele Experimente an Filmen helikaler organischer Moleküle auf eine sehr hohe Spinpolarisation der durch sie transmittierten Elektronen hin. In Monolagen solcher Moleküle treten bei Raumtemperatur longitudinale Spinpolarisationen von 60 bis 80 Prozent auf. Was führt zu dieser überraschenden Beobachtung?

Chirale Moleküle und Systeme gibt es bei identischem Aufbau in zwei Klassen, die durch Spiegelung nicht ineinander überführbar sind, den Enantiomeren (Infokasten). Sie machen einen großen Teil unserer natürlichen Umgebung aus. Alle biologischen Systeme auf der Erde nutzen nur genau eine Enantiomerenform der relevanten Moleküle, die meistens in Form von α-Helizes vorliegen. Bekannte Beispiele sind die DNA, Proteine, Peptide, Aminosäuren und Zucker. An Zuckerlösungen lässt sich in einem einfachen Experiment die Wirkung chiraler Moleküle und Strukturen auf linear polarisiertes Licht beobachten, dessen Polarisationsrichtung sich beim Durchgang dreht. (...)

One of the actual frontiers in physics is the study of matter exposed to extremely strong electromagnetic fields. In particular, highly charged ions form unique laboratories where such conditions are largely fulfilled. These species can be stored in the form of intense beams and used in collision experiments. For such investigations, precise spectroscopy of photons emitted in collisions of heavy ions with atoms is required. This emission gives details of the specific electronic transition mechanisms operating in strong fields as well as information on electronic structure of the exotic atomic systems (e.g. H-like uranium). Among others, details concerning photoionization of very heavy atoms can be revealed in such experiments when observing radiative electron capture (REC). Moreover, accurate measurements of electron binding energies are very well suited to deduce characteristic quantum electrodynamics (QED) phenomena in strong fields. QED, the basis and cornerstone of all present field theories, is the best confirmed theory in physics, however, precise tests in the strong-field limit are still pending.

Winzige gasgefüllte Blasen, die an Oberflächen haften, sind über Tage stabil. Die Ursache dafür wurde nun gefunden.

• 2/2012 • Seite 39

• 2/2012 • Seite 39Die drei Leben des Klaus Fuchs (1911 – 1988)

Klaus Fuchs wird gemeinhin mit einem der folgenreichsten Fälle von Wissenschaftsspionage in Verbindung gebracht: den Verrat von Geheimnissen des US-amerikanischen Atombombenprojektes an die Sowjetunion in den 1940er-Jahren. Doch Fuchs hatte auch vor und nach diesem „Verrat des Jahrhunderts“ ein Leben, das auf ganz spezifische Weise deutsche Zeitgeschichte widerspiegelt; nicht zuletzt sind seine wissenschaftlichen Leistungen keineswegs unbedeutend.

Klaus Fuchs wurde am 29. Dezember 1911 in Rüsselsheim geboren. Sein Vater war der Theologe Emil Fuchs, der als einer der ersten deutschen Pastoren schon vor dem Ersten Weltkrieg der SPD beitrat und später den Bund der Religiösen Sozialisten gründete.1) Klaus Fuchs wuchs so in einem Elternhaus auf, das gleichermaßen von protestantischen wie sozia-listischen Idealen geprägt war. Im Gymnasium, das er im thüringischen Eisenach absolvierte, fiel Fuchs durch herausragende Leistungen, besonders in Mathe-matik und den Naturwissenschaften auf. Gleichzeitig machte er durch politische Renitenz auf sich aufmerksam, die während des anschließenden Mathematikstudiums – zunächst in Leipzig und ab 1930 in Kiel – durch politische Organisationen kanalisiert wurde. 1930 folgte er seinem Vater und trat in die SPD ein. Er schloss sich auch dem Reichsbanner an, der paramilitärischen Organisation der Sozialdemokratie.

Bereits nach zwei Jahren wechselte Fuchs, wie auch seine drei Geschwister, zur Kommunistischen Partei und wurde Leiter der kommunistischen Studentenfraktion in Kiel. Dies machte ihn zum Gegenstand öffentlicher Anfeindungen und tätlicher Angriffe. Mit der Machtübernahme durch die Nationalsozialisten am 30. Januar 1933 wurde seine Lage zunehmend gefährlich, und nach dem Reichstagsbrand tauchte er in Berlin unter. Im August 1933 flüchtete er schließlich nach Paris und emigrierte im September 1933 nach England, wo er sich an der Universität Bristol ganz darauf konzentrierte, sein Studium fortzusetzen. Nicht zuletzt war Emigranten durch das Gastland jede politische Betätigung untersagt. Fuchs zeigte sich als ein ebenso ehrgeiziger wie brillianter Student. Bereits im Oktober 1935 schloss er seine Dissertation ab.2) Sein Doktorvater ist kein geringerer als der Pionier der modernen Festkörperphysik, Nevill Mott. Dies und seine glänzende Doktorarbeit, aus der mehrere Aufsätze hervorgingen, die bis heute in Standardwerken zur Festkörperphysik zitiert werden,3) wurden für Fuchs zum Eintrittsbillet in die akademische Welt. Mott hat rückblickend festgestellt, „für einen Mann solchen Kalibers habe ich eine große Karriere in der Physik vorausgesehen“.4) ...

Seit prähistorischer Zeit sind wichtige technologische Fortschritte einhergegangen mit fundamentalen Erkenntnissen in der Tribologie, der Wissenschaft von Reibung, Schmierung und Verschleiß zwischen zwei Oberflächen. Feuerstäbe, die durch Reibung chemische Reaktionen hervorrufen, sind ein historisches Beispiel für die Relevanz tribologischer Prozesse. Modernen Schmiermethoden ist es zu verdanken, dass der Lesekopf in einem Computer-Laufwerk in einem Abstand von lediglich 20 nm bei einer Geschwindigkeit von 20 m/s über die Festplatte ''fliegt''. Trotz solcher Fortschritte besteht kein wissenschaftlicher Konsens darüber, welche Prozesse auf molekularer Skala zu Reibung und Abrieb führen. Sowohl neuartige experimentelle Methoden als auch Computersimulationen erlauben immer tiefere Einblicke in die für die Tribologie relevanten mikroskopischen Vorgänge.

• 5/2021 • Seite 43 • DPG-Mitglieder

• 5/2021 • Seite 43 • DPG-MitgliederDie Hochschullehre ist zu einem gesellschaftlich wichtigen Forschungsgegenstand der Physik geworden.

Die Physik ermöglicht Erkenntnisse in vielen Gebieten, die der instrumentell unterstützten Wahrnehmung zugänglich sind. Zu den Forschungsgebieten zählt mittlerweile auch das Lehren von Physik an Hochschulen. Dort gelang es in jüngerer Vergangenheit zu beschreiben und zu erklären, was beim Erlernen von Physik passiert und wo und warum Hürden für Studierende auftreten.

Physikerinnen und Physiker untersuchen und modellieren seit jeher Phänomene ihrer Umwelt. Seit einigen Jahrzehnten untersuchen sie zudem das Lernen und Lehren der Physik an Hochschulen. Die entsprechende Forschung findet vor allem in Nordamerika statt. Dort hat sich mit Physics Education Research ein Teilgebiet der Physik entwickelt, das in Deutschland als Forschungsgebiet eher unbeachtet ist, dessen Erkenntnisse aber allmählich auch hierzulande in der Hochschullehre Einzug halten – und das nicht nur in der Physik.

Ohne Zweifel haben viele Studierende Schwierigkeiten, Physik zu erlernen. Liegt die Ursache eher in individuellen Eigenschaften wie mangelnder Vorbildung, Fähigkeiten oder Begabung? Sind die Schwierigkeiten vor allem von jemand oder etwas anderem verursacht, also durch die Rahmenbedingungen an Hochschulen oder die Kompetenz der Lehrenden? Oder ist die Angelegenheit komplexer? Wenn ja, wie lässt sich diese Komplexität beschreiben – im Sinne Einsteins „so einfach wie möglich, aber nicht einfacher“?

Bei diesen Fragen geht es darum, ein Modell für ein beobachtbares Phänomen zu erstellen – eine vertraute Tätigkeit in der Physik. Nehmen wir als Beispiel den Vorgang, bei dem ein nach oben geworfener Gegenstand zunächst langsamer wird. Lässt sich dies eher durch eine Eigenschaft des Gegenstands erklären – etwa dass sein Impetus geringer wird? Wird der Gegenstand aufgrund einer einzigen Wechselwirkung langsamer – beispielsweise durch gravitative Wechselwirkung mit der Erde? Oder ist die Situation komplexer, etwa weil der Gegenstand neben der Erde noch mit weiteren Objekten wechselwirkt? Wie lässt sich dieser Vorgang beschreiben? (...)

Free Access

Titelbild: Vakuum in Forschung und Praxis 3/2024

Free Access

Vakuumtechnik im Wandel – ViP auch!

Inhalt: Vakuum in Forschung und Praxis 3/2024

News: Vakuum in Forschung und Praxis 3/2024

Forschung: Vakuum in Forschung und Praxis 3/2024

Personen: Vakuum in Forschung und Praxis 3/2024

Tribological behavior of TiAlCrSiN coated cutting tools: Chip formation and friction analysis

Kirsten Bobzin, Christian Kalscheuer, Muhammad Tayyab

Mandy Höhn, Jean Philippe Beaupain, Eleonore Siebecke, Mario Krug, Sören Höhn

S. Brückner, D. Tasche, M. Bellmann, S. Josten, F. Wittland, B. Zeiß, C. Gerhard

Roots multi-lobe vacuum pumps with external compression: Comparison of effectiveness

A. Raykov, S. Salikeev, A. Burmistrov, M. Fomina

DVG: Vakuum in Forschung und Praxis 3/2024

Tagungen: Vakuum in Forschung und Praxis 3/2024

Termine: Vakuum in Forschung und Praxis 3/2024

Bezugsquellen: Vakuum in Forschung und Praxis 3/2024

Index/Impressum: Vakuum in Forschung und Praxis 3/2024

• 6/2022 • Seite 24 • DPG-Mitglieder

• 6/2022 • Seite 24 • DPG-MitgliederÜber die Abwanderung von Wissenschaftlerinnen und Wissenschaftlern in die USA nach Ende des Zweiten Weltkriegs

Mit dem Ziel, durch wissenschaftliche Erkenntnisse den Krieg im Pazifik möglichst zu verkürzen, begann im Juli 1945 ein zunächst geheimes US-Rekrutierungsprogramm für ausgewählte deutsche Wissenschaftlerinnen und Wissenschaftler. Nach Kriegsende wurde es unter dem Namen „Paperclip“ weitergeführt.

Nur wenige Themen haben die Politik in den vergangenen Jahren so sehr bewegt wie die Migration. Ein Hauptauslöser dafür, dass Menschen in ein anderes Land auswandern, sind kriegerische Konflikte mit all ihren zerstörerischen Konsequenzen. Auch die Geschichte Deutschlands im 20. Jahrhundert ist geprägt durch das Entfachen von zwei Weltkriegen, in deren Folge Millionen von Menschen verfolgt, ermordet oder vertrieben wurden.

Dieser Beitrag soll die Folgen des Zweiten Weltkriegs um eine weniger bekannte Perspektive ergänzen: eine Auswanderungsbewegung von deutschen und österreichischen Physikerinnen und Physikern nach Ende des Zweiten Weltkriegs in die USA. Teile dieser Geschichte, insbesondere die Überführung von Raketenwissenschaftlern zusammen mit Wernher von Braun und dessen Beteiligung am amerikanischen Raumfahrtprogramm, sind in einigen hervorragenden Büchern und Arbeiten, jedoch auch in einer größeren Anzahl weniger fundiert recherchierten und teils reißerischen Werken erzählt worden. Auch finden sich Karikaturen dieser Karrieren in populären Werken, etwa in der Figur des „Dr. Strangelove“ in Stanley Kubricks gleichnamigen Film von 1964. Im Folgenden wird der Blick hingegen auf Bereiche der Physik gelenkt, die bisher weniger im Zentrum des öffentlichen Interesses standen. (...)

• 9/2011 • Seite 49

• 9/2011 • Seite 49Brownsche Bewegung und Thermodynamik in der Relativitätstheorie

Thermodynamik, Diffusions- und Relativitätstheorie haben sich als Eckpfeiler der statistischen bzw. theoretischen Physik bewährt. Obwohl alle drei Gebiete wesentlich durch die Arbeiten Albert Einsteins geprägt wurden, erwies sich ihre Vereinheitlichung lange Zeit als schwierig. Heute ermöglichen stochastische Differentialgleichungen einen eleganten Zugang, um relativistisch konsistente Diffusionsmodelle zu formulieren, und sie eröffnen neue Wege, um Transport- und Thermalisierungsprozesse im Rahmen der Relativitätstheorie zu modellieren.

Albert Einsteins Arbeiten von 1905 haben die Physik nachhaltig geprägt [1]: seine Erklärung des photoelektrischen Effekts, die Erkenntnis des thermostatistischen Ursprungs1) der Brownschen Bewegung und nicht zuletzt die Formulierung der Relativitätstheorie. Die darauf folgenden Bestrebungen, quantenmechanische und relativistische Konzepte zu vereinheitlichen, waren zentraler Forschungsgegenstand der Physik des letzten Jahrhunderts. Sie führten u. a. zu quantenfeldtheoretischen Methoden, die ihren bisherigen Höhepunkt im aktuellen Standardmodell der Elementarteilchen finden. Im Gegensatz dazu erwies sich die Einbettung von Brownschen Bewegungskonzepten [2−4] und Thermodynamik [5, 6] in die Relativitätstheorie lange Zeit als problematisch.

Ursprünglich bezeichnet Brownsche Bewegung die Zufallsbewegung mesoskopischer Partikel in einer molekularen Flüssigkeit, die der Botaniker Robert Brown 1827 erstmals detailliert untersucht hat. Einstein, Paul Langevin und Norbert Wiener entwickelten mathematische Techniken, um dieses Phänomen zu quantifizieren. Diese Methoden finden heute vielfältige Anwendungen in der Physik, Mathematik, Biologie und Chemie [2, 3]. Sie bilden die Grundlage moderner Diffusionsmodelle, die allgemein darauf abzielen, die quasi-zufällige Dynamik ausgewählter Freiheitsgrade („Brownsche Teilchen“) in einem komplexen Hintergrundmedium („Wärmebad“) mit partiellen oder stochastischen Differentialgleichungen statistisch zu beschreiben. Eine solche Unterteilung in primäre und sekundäre Freiheitsgrade ist in der Regel dann sinnvoll, wenn eine natürliche Skalentrennung vorliegt. Dies ist z. B. der Fall, wenn Austauschprozesse im Wärmebad sehr schnell ablaufen, sich die typischen Massen- und Längenskalen seiner Bestandteile deutlich von denen des Brownschen Teilchens unterscheiden und sich die Wechselwirkungen mit dem Hintergrundmedium näherungsweise als unkorrelierte Stöße auffassen lassen. Ein anschauliches Beispiel ist ein kleiner Farbtropfen, der sich in Wasser ausbreitet, d. h. von einem stark lokalisierten Ausgangspunkt in die umgebende Füssigkeit diffundiert. Die Farbpartikel spielen hierbei die Rolle Brownscher Teilchen und die Wassermoleküle die des Wärmebads. ...

• 7/2015 • Seite 41

• 7/2015 • Seite 41Die Allgemeine Relativitätstheorie etablierte sich von 1915 bis 1990 nur langsam als eigene Disziplin.

Die Allgemeine Relativitätstheorie (ART) war zwar nach der Bestätigung der gravitativen Lichtablenkung im Jahr 1919 in aller Munde, prägte aber die physikalische Forschung im Gegensatz zur aufkommenden Quantenmechanik kaum. Zwar befassten sich immer wieder einzelne Physiker mit Fragen der ART, aber eine Institutionalisierung im Lehr- und Forschungsbetrieb fand im deutschen Sprachraum erst deutlich nach dem Zweiten Weltkrieg statt.

Mit der Aufstellung der Feldgleichungen für seine relativistische Gravitationstheorie vollendete Albert Einstein im November 1915 in Berlin seine jahrelangen Bemühungen. Zu dieser Zeit waren viele deutsche und österreichische Naturwissenschaftler und Mathematiker wegen des Ersten Weltkriegs zum Militär eingezogen worden. Schon im Dezember 1915 schickte der Astronom Karl Schwarzschild von der russischen Front aus eine exakte Lösung für einen kugelsymmetrischen Stern (Innen- und Außenraum) an Einstein, die fünfzig Jahre später der Prototyp für ein „Schwarzes Loch“ werden sollte. Jeder, der sich mit partiellen Differentialgleichungen auskannte, konnte sofort etwas zur neuen Theorie beitragen. Daher waren wichtige exakte Lösungen der Einsteinschen Feldgleichungen wie etwa die Reissner-Nordström und – für die Feldgleichungen mit kosmologischer Konstante – die de-Sitter-Lösung schon bis 1917 gefunden.

Die an Physik interessierte Öffentlichkeit wies 1916 ein Büchlein des jungen Potsdamer Astronomen Erwin Freundlich auf die neue Theorie hin. 1917 legte Einstein eine eigene Darstellung für einen größeren Leserkreis vor: „Über die spezielle und die allgemeine Relativitätstheorie, gemeinverständlich“. Auch Philosophen wie Moritz Schlick richteten schon 1917 ihr erkenntnistheoretisches Interesse auf Einsteins Gravitationstheorie. Einstein korrespondierte mit praktisch allen, die über Allgemeine Relativitätstheorie forschten oder sich dazu kritisch äußerten. Die von ihm vertretene physikalische Bedeutung der allgemeinen Kovarianz seiner Theorie stellte Erich Kretschmann 1917 in Frage. Die Fachwelt hatte also bereits vor dem Ende des Ersten Weltkriegs wesentliche Eigenschaften der ART beschrieben und Folgerungen aus ihr gezogen (kosmologische Modelle, Gravita-tionswellen)...

• 5/2022 • Seite 35 • DPG-Mitglieder

• 5/2022 • Seite 35 • DPG-MitgliederEin Blick auf Quantenfluktuationen und ihre Konsequenzen

Fluktuationen sind allgegenwärtig. Sie bilden einen fundamentalen Baustein der Quantenmechanik und sind verantwortlich für die unterschiedlichsten Phänomene von der Biologie bis zur Kosmologie. So existieren fern jeder klassischen Intuition Kräfte zwischen nichtmagnetischen und elektrisch neutralen Objekten. Diese Kräfte entstehen durch Quantenfluktuationen wie aus dem Nichts und gewinnen immer mehr an Bedeutung für verschiedene Zukunftstechnologien.

Mit pantha rhei (Alles fließt) werden manchmal die Lehren des griechischen Philosphen Heraklit zusammengefasst. Sie entsprechen dem Verständnis von kausaler Verknüpfung sowie einem ständigen Wandel in der Natur. Viele Jahrhunderte später hat die Quantenmechanik unser Weltbild revolutioniert. Die nicht-intuitiven Resultate der Quantentheorie bieten Raum für Spekulationen und werden bis heute debattiert. Dazu zählt die Erkenntnis, dass jede physikalische Größe eine intrinsische Unsicherheit mit sich trägt. Solche Quantenfluktuationen verbinden jede Observable mit statistischem Rauschen. Heute wissen wir: Alles rauscht. Was sich wie eine theoretische Kuriosität anhört, hat weitreichende Implikationen im gesamten Spektrum der Physik. Denn Quantenfluktuationen sorgen für messbare Effekte mit wachsender Bedeutung für moderne Nano- und Quantentechnologien.

Mathematisch gesehen sind Quantenfluktuationen die Konsequenz der nicht-kommutativen Struktur der Quantenmechanik, also der Tatsache, dass die Reihenfolge von Messungen wichtig ist. So können wir niemals „gleichzeitig“ die Position x und den Impuls p eines Körpers exakt bestimmen. Als Konsequenz ergibt sich die Unschärferelation von Heisenberg. Für eine eindimensionale Dynamik gilt Δx Δp ≥ ħ/2, wobei ħ = h/(2π) die reduzierte Planck-Konstante ist. Je kleiner die Unschärfe im Ort Δx, desto ungenauer wird der Impuls Δp – und umgekehrt. (...)